Comme à l’accoutumé j’aime résumer l’année passée en termes de SEO News et d’établir un Roadmap pour l’année à venir en termes de bonnes pratiques. Le changement cette année c’est que j’ai un rôle de directeur marketing, ce qui me permet de revêtir une casquette plus large en termes de tactiques.

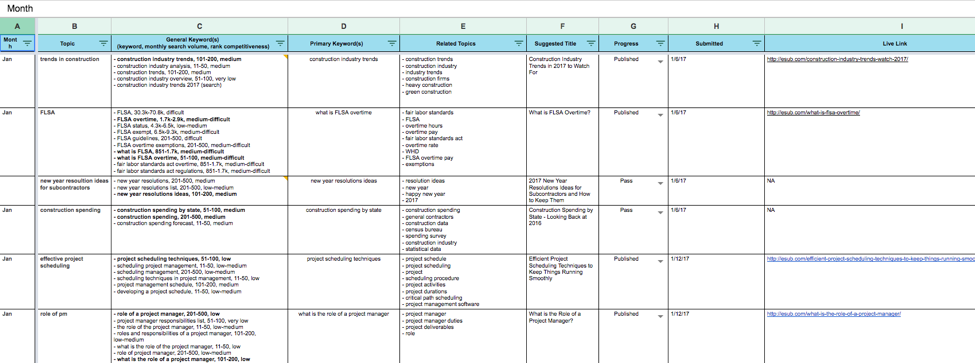

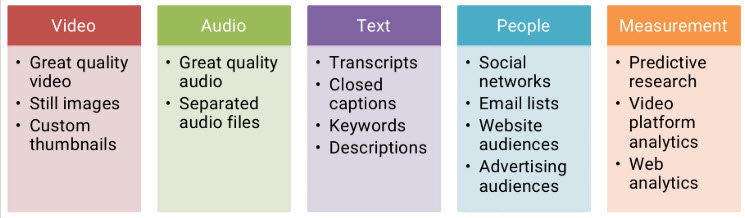

Dans la figure ci-dessous partagée par nos amis de MOZ récemment en Novembre 2019, voici les moyens les plus efficaces pour acquérir des prospects et les nourrir :

Clairement la recherche domine et notre avenir en tant que SEO est assuré! Assurons-nous de produire des recommandations justifiées par des sorties de Google ou Bing pour être pris au sérieux SVP 😊

Clairement la recherche domine et notre avenir en tant que SEO est assuré! Assurons-nous de produire des recommandations justifiées par des sorties de Google ou Bing pour être pris au sérieux SVP 😊

Il y a des topiques qui vont rester de notre dernier billet « tendances SEO 2019 » comme E-A-T et le JS mais cette année nous allons élargir notre champs de vision pour inclure des pratiques qui n’ont pas forcément un impact direct sur le trafic organique mais plutôt sur le rayonnement de la marque. Sans plus tarder voici la table de matières

Table des Matières

- Technique du site : architecture, crawlabilité et indexabilité

- Contenu : mince, non fiable et non original

- Backlinks : le contexte l’emporte sur le domaine autorité

- Social Graph : montrez patte blanche à Google

- Knowledge Graph : Google vérifie ce que vous dites

- E-A-T : ne soyez pas une adresse web mais plutôt une source fiable

- JS : amusez-vous Google va comprendre vos vannes

- BERT : Google se passera bientôt des mots clés

- Recherche Vocale : encore et toujours

- Recherche visuelle : l’opportunité manquée des référenceurs

- Recherche locale : la plus efficace des stratégies SEO

- Recherche Mobile : plus de la moitié des recherches Google

- Conclusion pour les tendances 2020

Technique du site : architecture, crawlabilité et indexabilité

Retour aux bases du SEO et à la pyramide de Moz pour une stratégie efficace :

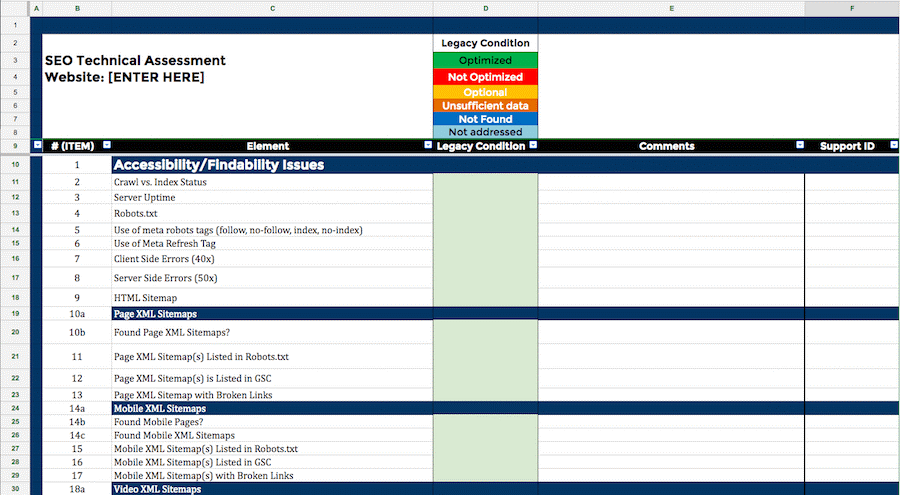

Dans cette rubrique nous voulons que CHAQUE page du site avec une valeur ajoutée pour l’utilisateur soit découverte de manière naturelle via le crawl du site, qu’elle soit rapide à charger et qu’elle soit indexable telle que nous l’avons conçue sur le doc Word de départ par exemple. Voici une checklist pour vérifier si vous avez bien fait votre travail d’optimisation :

Dans cette rubrique nous voulons que CHAQUE page du site avec une valeur ajoutée pour l’utilisateur soit découverte de manière naturelle via le crawl du site, qu’elle soit rapide à charger et qu’elle soit indexable telle que nous l’avons conçue sur le doc Word de départ par exemple. Voici une checklist pour vérifier si vous avez bien fait votre travail d’optimisation :

ARCHITECTURE

- Structure et hiérarchie: le pages les plus importantes mises de l’avant

- URL: structure des URLs optimisées pour les moteurs et utilisateurs

- Choix des noms de fichiers: html, images, pdfs…

- 404 Personnalisé : une vraie 404 avec le bon code serveur

- Maillage interne: absence de pages orphelines

ACCESSIBILITÉ

- Fichier Robots.txt: qu’autorise-t-on pour le crawl et qu’élimine-t-on

- Outils pour les webmasters de Google: configuration et analyse des erreurs

- Liens rompus et redirigés: code erreur 404, 3xx et 5xx à éviter

- Textes alternatifs des images: avons-nous des fall back descriptifs

- Temps de chargement des pages: le FCP est-il en dessous de 2s

INDEXABILITÉ

- Contenu dupliqué : donnons-nous à la bête des pages inutiles à manger

- Internationalisation: le chemin relatif, les hreflang, le maillage alternatif

- Index sanity check: avons-nous un gonflage de l’index (dilution d’autorité)

- Canonicalisation: une et une seule version pour chaque contenu peut être indexée

- Pages dynamiques: navigation à facette, interaction client, ciblage géographique

Bien entendu, cette liste n’est pas exhaustive et je vous recommande de faire votre propre checklist en compilant les données des différents experts :

Passez en revue toutes les listes disponibles et construisez la vôtre qui s’adapte le mieux à votre situation. Par exemple, un site non pénalisé n’a pas besoin de passer au travers d’une évaluation des mauvaises pratiques. Concentrez vous sur le fondamental et surtout ne comptez pas sur les moteurs pour combler vos lacunes. Un site aujourd’hui avec des paramètres d’URL dynamiques a besoin d’une configuration manuelle dans la search console même si les moteurs ont identifié les paramètres, il faut leur dire quoi faire avec. Souvent j’ai des clients qui font trop confiance dans les moteurs pour interpréter le site que ce soit le JS, les iFrame ou encore tout simplement les trailing slashes. Pourtant pour ce dernier point qui semble douteux, @JohnMu a bien précisé que les 2 URLs ne sont pas pareilles :

Contenu : mince, non fiable et non original

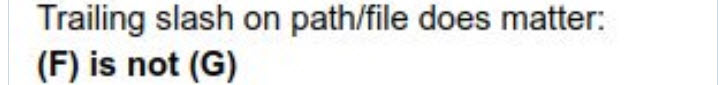

« Le contenu est roi » ce ne sont pas des paroles en l’air. Le contenant est facile à concevoir, on s’oriente de plus vers des sites épurés où l’UX mise sur la simplicité à la LinkedIn ou Twitter:

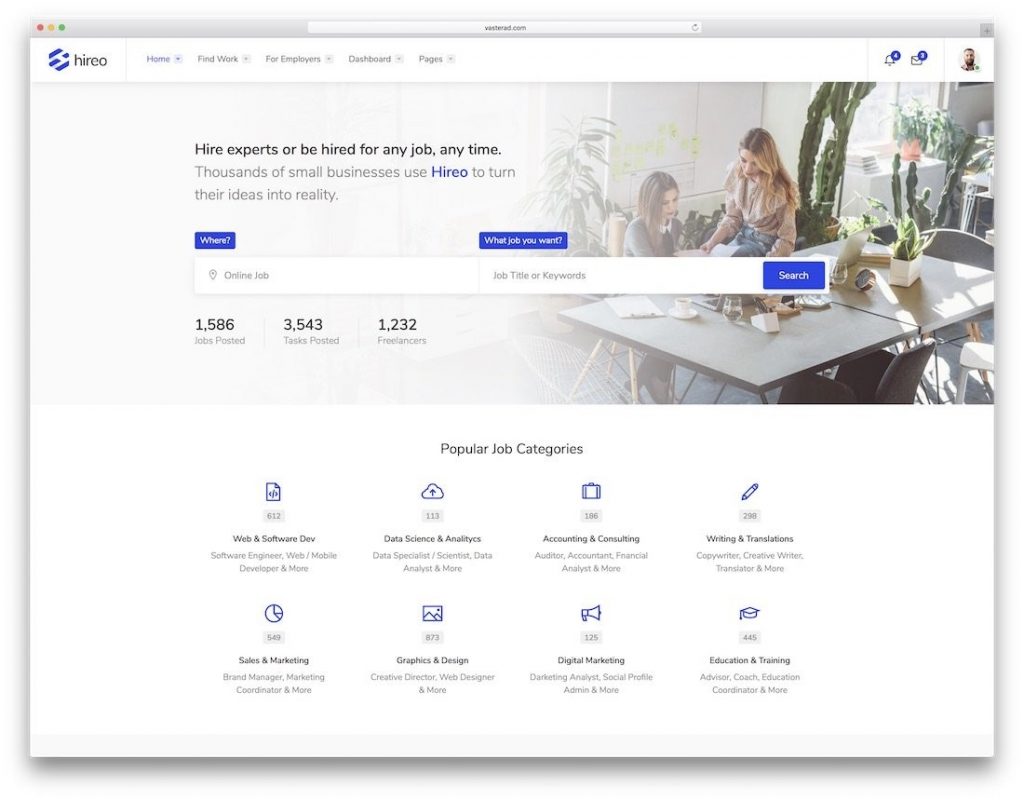

Pour le contenu c’est toute une autre histoire où nous voyons les formats diversifiés à profusion : textes, images, vidéos, infographies et j’en passe. Quel que soit le format, ne publiez pas du contenu pour le SEO mais plus pour les usagers (déjà entendu) car ce sont eux qui vont donner la crédibilité à votre page. Un fort taux de rebond, pogo sticking, temps passé sur la page très bas…. Autant d’indicateurs qui font que les moteurs vont juger de la pertinence de votre page :

Voici une petite checklist pour évaluer le contenu de votre site :

- Recherche de mots clés: les pages répondent-elles aux termes recherchés

- Balises de titre: sont-elles optimisées pour les moteurs et les utilisateurs

- Méta descriptions: encouragent-elles les utilisateurs à cliquer au lieu de scroller

- Étiquettes d’en-tête (headings): sont-elles descriptives des différentes sections du document

- Contenu riche et unique: la rédaction a-t-elle été au bout de ce qui se fait de mieux ?

- Interconnexion des pages: avons-nous mis les ancres textes pour créer la fameuse roue

- Contenu syndiqué et scrapé : avons-nous mis du « noindex» sur les pages non originales

Encore une fois cette liste n’est pas exhaustive, je vous conseille de faire la vôtre en fonction de la situation. Par exemple, un site frappé par Panda ou par un « Core Algorithm Update » aura sa propre checklist que vous pouvez trouver sur le web en cherchant bien.

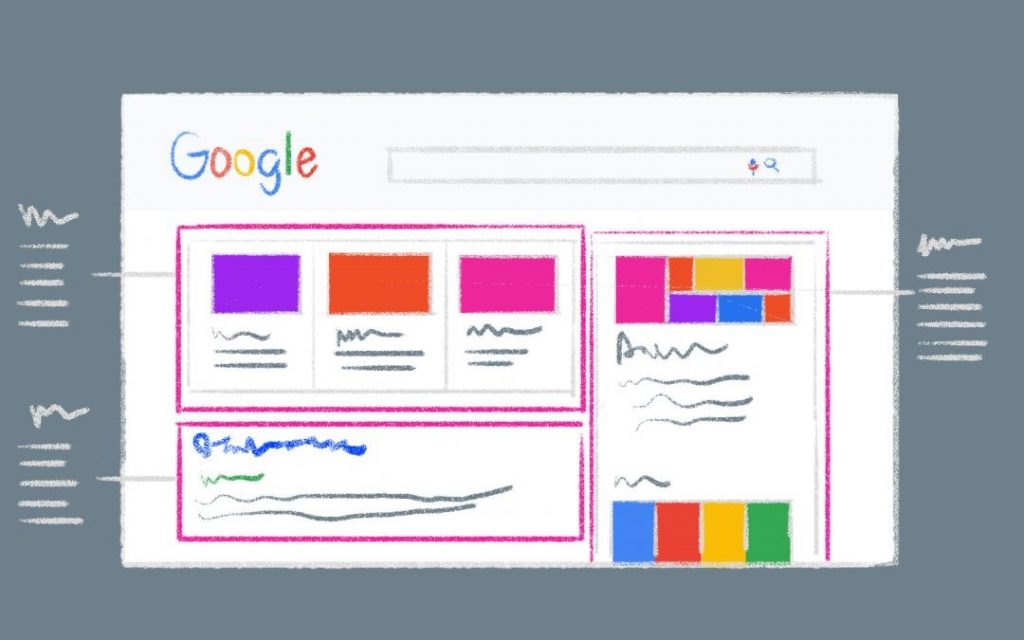

Cherchez aussi la diversité des formats en faisant une étude comparative des compétiteurs. Google a tendance maintenant à produire dans ses résultats de recherche une variété de contenus comme les news, les images, les vidéos et j’en passe (SERP Features) :

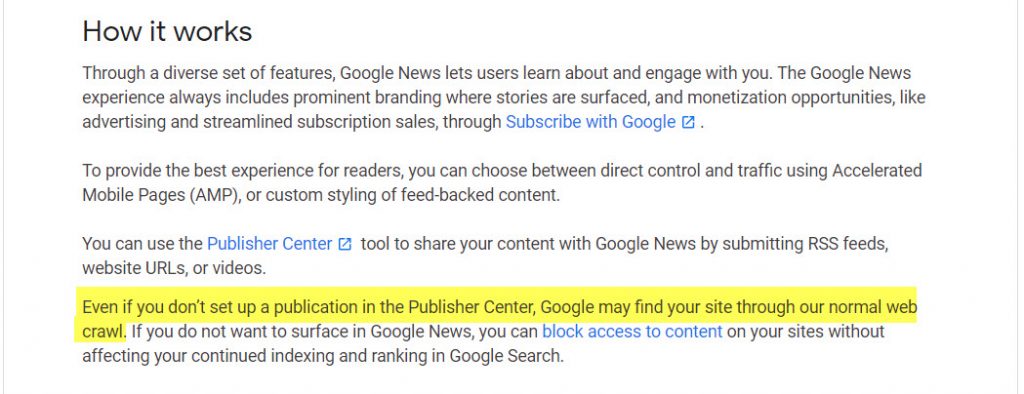

Par exemple, et c’Est tout récent, ça date de cette semaine, Google vient de décider que les news vont provenir du Web, plus besoin d’être catégorisé Publisher comme dans le temps de Google News :

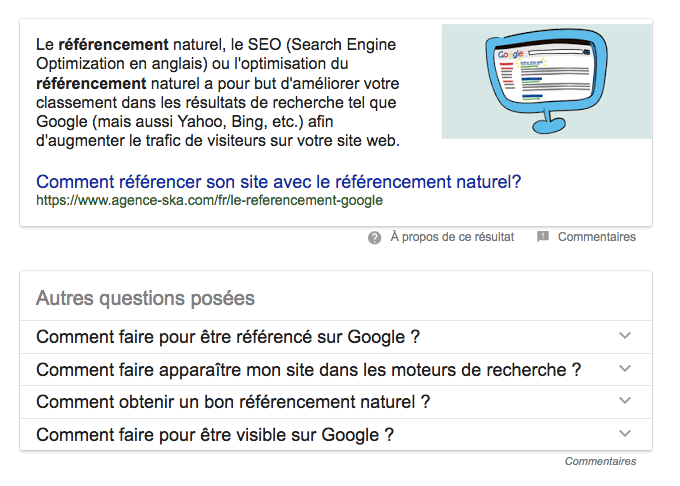

Un autre exemple, Google va produire des Featured Snippets là où il pense que ça améliorer l’expérience de son utilisateur. Bien que vous ne soyez pas maître de ce format, assurez vous de vérifier pour les pages qui fon du sens que vous avez optimisé pour cette fonctionnalité. Apprenez en plus sur mon billet SEO DONNÉES STRUCTURÉES ET RICH SNIPPETS PAR GOOGLE

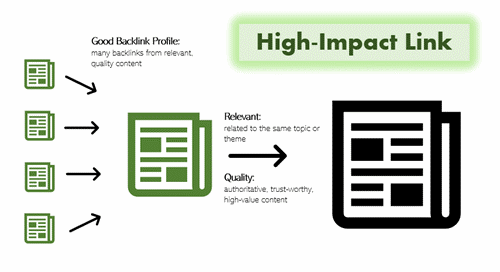

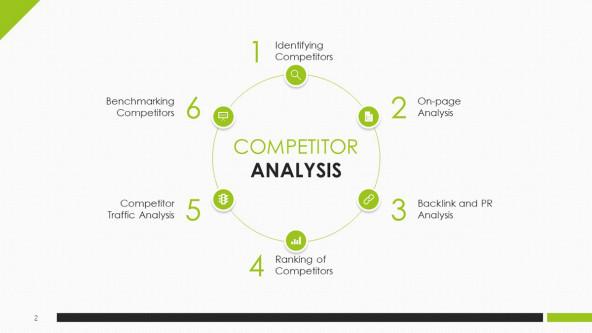

Backlinks : le contexte l’emporte sur le domaine autorité

Hummm là on est tous dans le même bateau, on sait comment ça marche mais pour l’implémentation chacun sa recette ! Du PBN aux forums, du guest posting aux commentaires de blog, il y a à boire et à manger. Mais le guideline on le connaît, qu’est ce qui fait qu’un backlink est percutent ? trois qualités fondamentales pour le juger : autorité du site référent, topique convoyée via l’ancre texte, contexte du site géographique (le plus proche, le mieux) et de manière générale combien semble-t-il légitime (ex : l’ancre dans le titre, le branding dans le premier paragraphe, les Co-citations sur la pièce de contenu.

Voici une checklist de l’audit de backlinks utile pour démarrer :

- Vue d’ensemble liens externes et domaines référents: inventaire et comparaison

- Types de liens: liens textes, images, IFrame…

- Distribution des liens de qualité pour les compétiteurs: liens par Domain Autorité

- Ventilation de la profondeur des liens: vers la home versus page profonde

- Ventilation des liens par ancre texte: ancres de marque versus money keywords

- Lien Dofollow versus Nofollow: il faut un équilibre qui semble normal selon l’industrie

- Extensions des domaines référents : le contexte géographique et TLD

- Pages liées: vérification que la destination correspond à la topique convoyée

- Liens dangereux: SVP utilisez le disavow file ça sert à se prémunir du jugement auto

Pour une analyse en profondeur je vous renvoie à mon billet sur l’analyse des backlinks : L’ANALYSE COMPÉTITIVE DU PROFIL DES LIENS ( BACKLINKS )

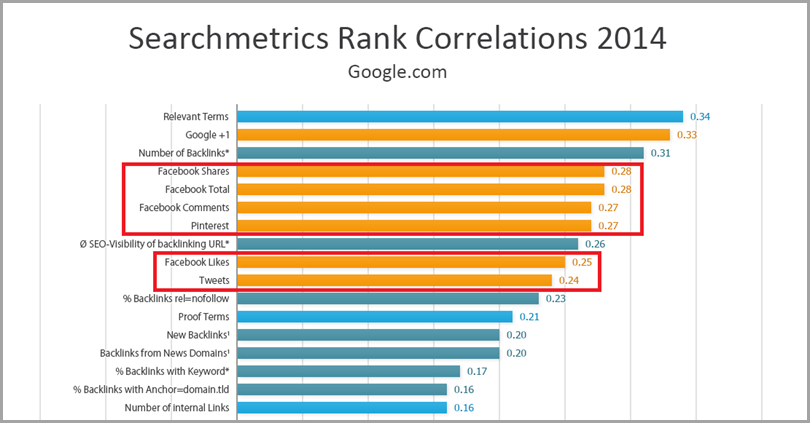

Social Graph : montrez patte blanche à Google

Oups là j’ai des clients qui me disent je n’aime pas Facebook ! ce n’est pas là la question. Les moteurs crawlent et indexent les contenus qui ne sont pas bloqués par le robots.txt comme les statuts Twitter, les pages Facebook, les groupes Linkedin (non fermés) et j’en passe. Dans ma formation, on m’a inculqué l’importance de la vie privée et je la respecte. Mais dans un domaine de compétition féroce dans les résultats de recherche, on ne peut se passer des armes qui vont faire la différence. Voici une image qui en di long sur l’importance des médias sociaux dans le SEO :

Oui je sais ça date de 2014 et même Google plus était encore vivant en ce temps-là. Mais les choses n’ont pas changé de ce point de vue, seules les plateformes ont changé ! Searchmetrics et Moz s’entendent pour dire que le poids de l’engagement des suiveurs dur les médias sociaux est déterminant quand il s’agit de départir deux concurrents à force égale.

Amplification, Flying Wheel, Link Baiting …etc. autant de termes qui sont utilisés quand on parle de médias sociaux et SEO mais au bout du compte c’est une histoire d’amour qui est née à contre cœur :

Ne faisons pas la fine bouche SVP et utilisons-les à bon escient en commençant par Facebook pour la popularité, Twitter pour la fraîcheur et LinkedIn pour la légitimité.

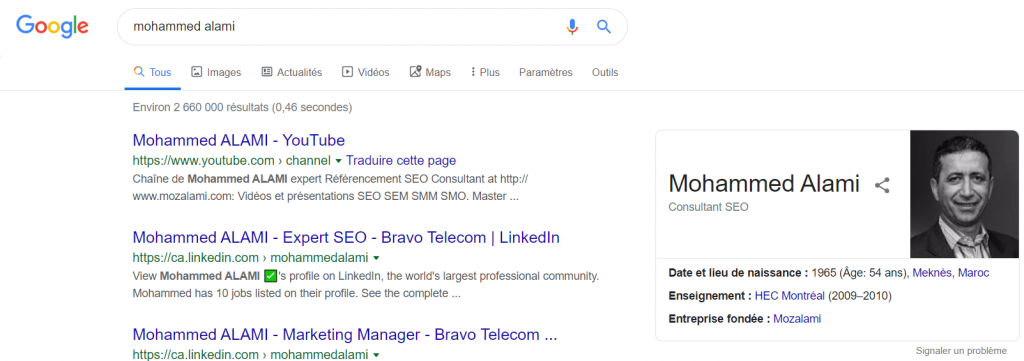

Knowledge Graph : Google vérifie ce que vous dites

S’il y a bien une topique qui m’est chère c’est bien celle-ci, Le Knowledge graph en gros est ce que sait Google de vous en dehors de votre site web : Wikipédia, Freebase, Entités web…etc. autant de sources pour les moteurs pour vérifier ce que vous dites.

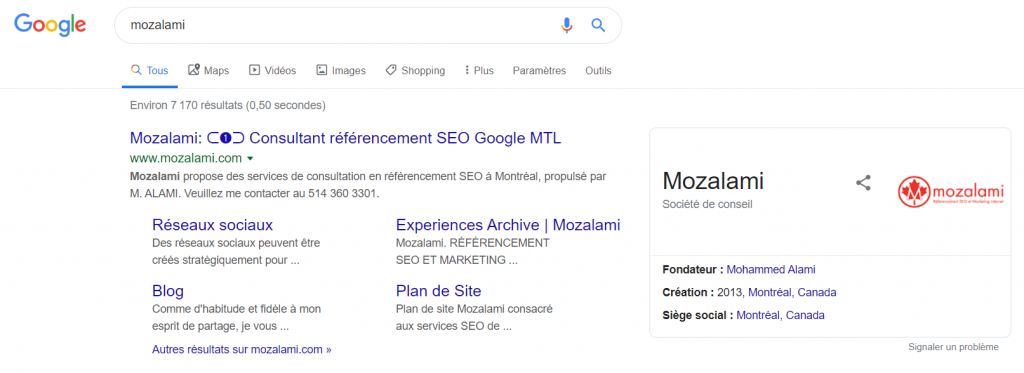

Prenons mon exemple dans la SERP ça donne :

Et Google lie Mozalami à mon profil en tant qu’entreprise fondée :

Je ne vous dirai pas comment j’ai fait ça mais cela me permet de me classer premier sur « consultant seo montreal » sans que je sois actif dans les réseaux ou les forums (en spammant en règle générale). La puissance des entités web est phénoménale quand on sait s’en servir :

Oui ça date ça aussi mais ça n’a fait que prendre de l’ampleur avec Hummingbird d’abord puis avec RankBrain et maintenant avec BERT qui parle notre langage ça va être encore plus facile pour Google.

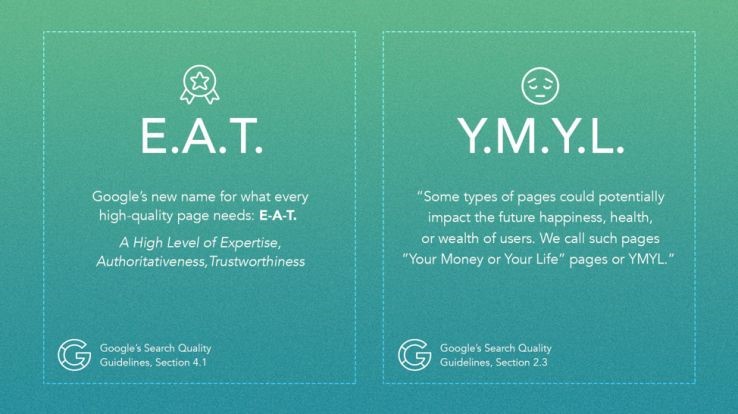

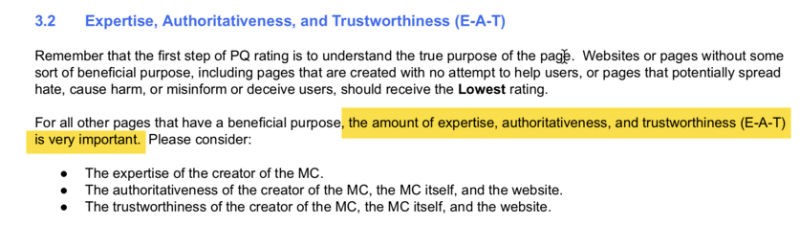

E-A-T : ne soyez pas une adresse web mais plutôt une source fiable

Le contenu des sites web passe désormais par une validation des moteurs de recherche quant à l’expertise, l’autorité et la confiance dont feront l’objet les pages une fois mises en ligne.

YMYL is a quality rating for content that stands for “Your Money or Your Life« . Google doesn’t just care about delivering the most relevant information — they also want to deliver the correct information.

Ainsi, en matière de santé, de problèmes financiers et de sécurité, Google ne souhaite pas proposer de liens vers des pages proposant des conseils, des opinions ou des sites Web potentiellement frauduleux. Google souhaite être aussi certain que possible de recommander des sites affichant un niveau élevé de compétence, d’autorité et de confiance – c’est ce que E-A-T représente!

- E-A-T: E-A-T signifie Expertise, autorité et confiance – trois facteurs que Google utilise pour mesurer le degré de confiance qu’il doit accorder à une marque ou à un site Web. Google souhaite offrir à ses clients (utilisateurs de moteurs de recherche) la meilleure expérience possible. Il souhaite uniquement promouvoir les sites Web auxquels il fait entièrement confiance.

- YMYL: Your Money or Your Life. Il s’agit principalement de sites de santé, finances, droit…

Le type d’informations de ce genre de sites, si elle est présentée de manière inexacte, mensongère ou trompeuse, pourrait avoir une incidence directe sur le bonheur, la santé, la sécurité ou la stabilité financière du lecteur. Autrement dit, les enjeux sont importants pour ce type de contenu.

Source : search quality evaluator guidelines

Ci-dessous, nous reproduisons en résumé les résultats d’analyse à la suite de la mise à jour du 12 Mars 2019. Voici une checklist pour évaluer le score E-A-T potentiellement accordé par Google :

- Examiner et aborder la qualité du contenu. Surfacer tout contenu mince ou de faible qualité et le manipuler de manière appropriée. Cela pourrait signifier améliorer le contenu de qualité médiocre, modifier ce contenu ou ne pas l’indexer.

- Analyser la configuration technique SEO et résoudre les problèmes que vous rencontrez aussi rapidement que possible. Par exemple, les problèmes canoniques, les problèmes de rendu, des problèmes d’exploration, etc.

- Analysez objectivement votre situation publicitaire. Avez-vous des publicités agressives, perturbatrices ou trompeuses?

- Existe-t-il des barrières d’expérience utilisateur (UX) sur votre site? Êtes-vous frustrant pour les utilisateurs? Si tel est le cas, supprimez toutes les barrières et rendez votre site facile à utiliser. Ne pas frustrer les utilisateurs.

- Sur cette note, répondez-vous et / ou dépassez-vous les attentes des utilisateurs? Passez en revue les requêtes conduisant à votre site, puis les pages de destination recevant ce trafic. Identifier les lacunes et les combler.

- Assurez-vous que les experts écrivent et révisent votre contenu (surtout si vous vous concentrez sur des sujets liés à YMYL). Il est clair que Google recherche une expertise lorsqu’il fait correspondre le contenu aux utilisateurs.

- Construisez les bons liens, et pas seulement de nombreux liens. Il ne s’agit pas de la quantité, mais de la qualité. Nous avons appris que Google évalue (partiellement) E-A-T via PageRank, qui provient de liens sur le Web. Utilisez une stratégie de contenu forte ainsi qu’une stratégie sociale forte pour créer des liens naturellement.

En somme, il s’agit de se montrer comme expert dans son domaine mais attention il ne suffit pas de le dire, il faut le prouver. Rappelez-vous que Google vous observe comme décrit ci-dessus en construisant les entités web et en les reliant aux contenus de votre site : passez-vous le test ?

Pensez-vous que cette image passe le test de E-A-T quand on met Phantom comme algorithme ou les mises à jour de Google telles que Panda et Penguin ? cet auteur mérite d’être poursuivi pour mauvaise information. Qui va le faire ? bien entendu Google avec son E-A-T score ! d’ailleurs il n’y a pas même pas d’auteur désigné sur la page source : bref ça va faire du bien à la communauté SEO aussi 😉

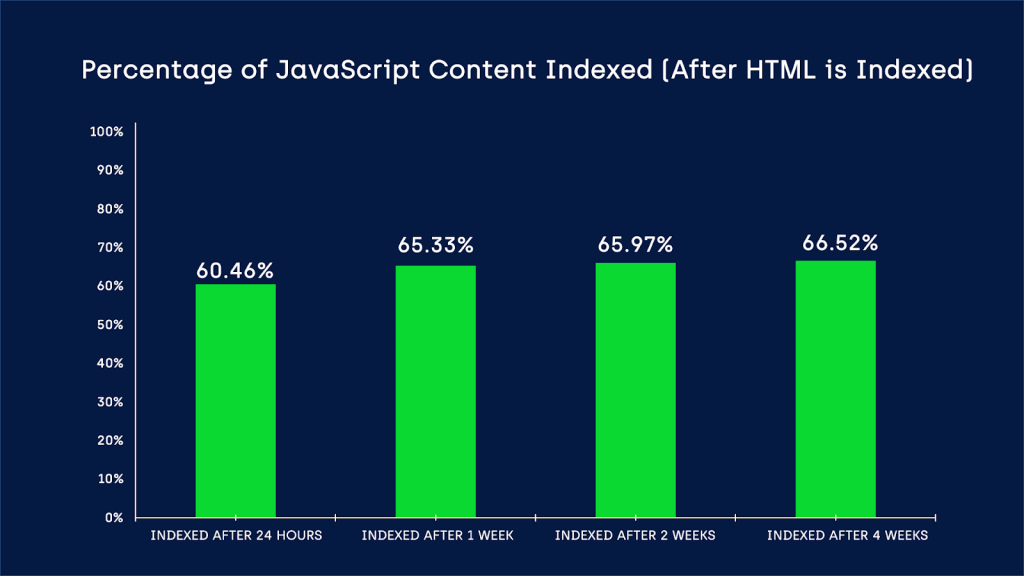

JS : amusez-vous Google va comprendre vos vannes

Ah le JS (JavaScript) lui il n’est pas annoncé pour mourir comme Flash en 2020 donc il faut composer avec ! J’avais déjà produit du contenu là-dessus dans mon article tendances 2019 :

- HTML – Hypertext Markup Language sert d’ossature ou d’organisateur de contenu sur un site. C’est la structure du site Web et la définition du contenu statique.

- CSS – Les feuilles de style en cascade sont la conception, le faste, le glam et le style ajoutés à un site Web.

- JavaScript – JavaScript sert l’interactivité et est un composant essentiel du Web dynamique.

Honnêtement je n’ai pas grand-chose à rajouter à ce sujet sinon les 3 points ci-dessous :

Google est capable de mieux comprendre le JS

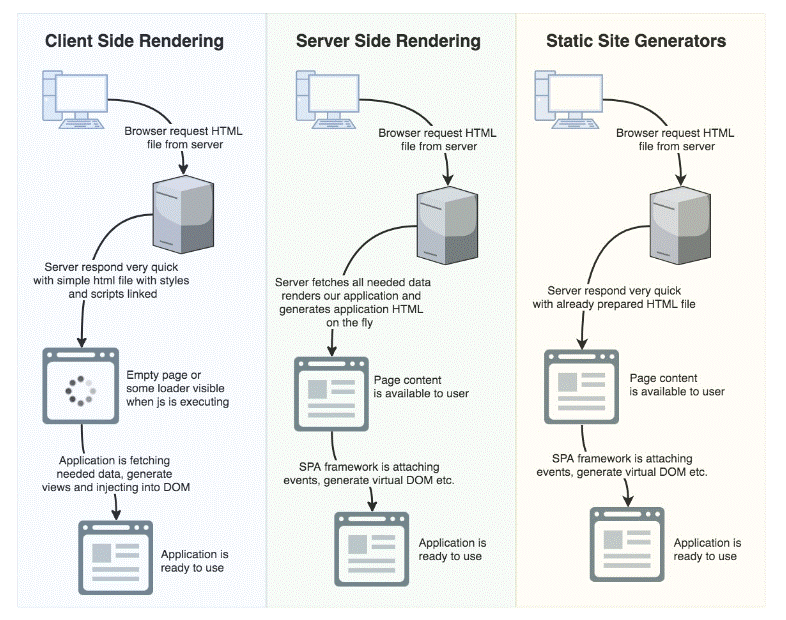

Googlebot fonctionnant sur la version la plus récente version de Chrome, le contenu JavaScript sera indexé plus rapidement que jamais, il est évident que Google améliore l’indexation de JavaScript. Mais les retards d’indexation JavaScript restent un problème majeur. Ci-dessous l’étude à ce sujet :

On voit bien que même après 4semaines d’attente, seulement 66.25% du contenu JS sera indexé. J’ai eu un souci de ce genre avec un site dans le passé et j’ai pu le résoudre avec Prerender.io qui est génial!

Google fait de plus en plus d’éducation pour le JS

Quand Google décide de résoudre un problème il y arrive. Et il a posé le premier pas en créant un site dédié à ce genre d problème d’indexation comme rapporté par Martin Splitt de Google:

So, this was the last episode we’ve recorded for the #javascript #seo series so far… 😭

But hey, on the bright side: Time for new episodes! 😎

⚡We want YOUR feedback – tell us what would you like to see in future episodes in this form:

👉 https://t.co/ueGj6zQ8wu 👈 https://t.co/PrWzS1xpMp

— Martin Splitt @ 🇨🇭🏡 😴😴😴😴 (@g33konaut) April 18, 2019

Les 2 ressources sont ci-dessous :

- https://developers.google.com/search/docs/guides/javascript-seo-basics#web-components

- https://developers.google.com/search/docs/guides/fix-search-javascript

Alors passez du temps là-dessus si vous avez un cas problématiques bien de choses on changé et c’est fini les hashbang et fragments autrefois suggérés par google guidelines.

Plus de détails techniques lors du dernier TechSEO Boost de Boston 2019

Y a un gars que je suis et qui me fait toujours plaisir quand je demande conseil : Cyrus Shepard

Voici son post épinglé sur Twitter :

The 10 Most Critical SEO Success Factors 🚀

1 Keyword Targeted

2 Fresh &

3 Unique Content

4 Satisfies User Intent w/

5 Expertise, Authority, and Trust

6 Crawlable + Accessible to Search Engines

7 Speed

8 Built for Multiple Devices

9 Earns a High # of Clicks +

10 Quality Backlinks— Cyrus (@CyrusShepard) January 2, 2019

Et dans un autre post il dit que la présentation de TechSEO Boost est la meilleure de la planète, alors regardez la, on parle de régressions JavaScript et d’autres concepts que je ne comprends pas ☹

Quoi qu’il en soit et peu importe à quel stade êtes-vous familier avec les régressions JS, je vous conseille d’y aller pour le moment avec le prérendering du côté serveur (SSR).

BERT : Google se passera bientôt des mots clés

Ah encore un nom à retenir ! non je pense que ça vaut le coup car de l’aveu de Google ça serait la plus grosse révolution dans la recherche depuis le lancement du moteur. Pas convaincu ? lisez plutôt le billet de Google là-dessus : Understanding searches better than ever before

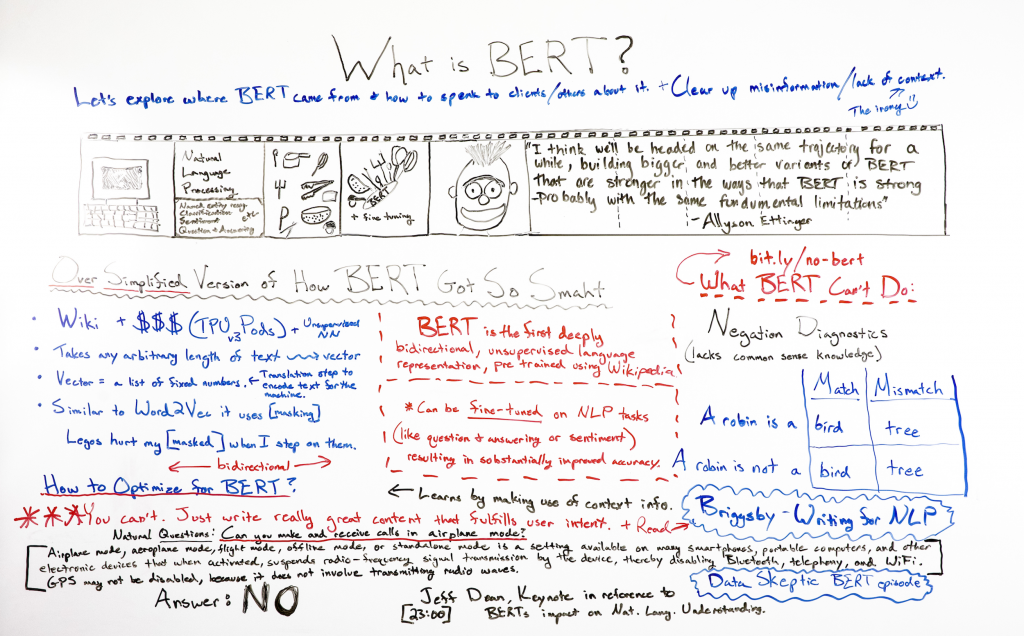

Alors que fait cette bête ? Google dit que l’année dernière ils ont introduit une technique (open-source) basée sur un réseau de neurones pour la préformation au traitement du langage naturel (NLP) appelée Représentations de l’encodeur bidirectionnel des transformateurs (en anglais « Bidirectional Encoder Representations from Transformers » d’où le BERT pour faire court. Cette technologie permet à quiconque de former son propre système de réponse aux questions à la pointe de la technologie.

Okay mais qu’est-ce que ça mange ne hiver ? je vous laisse découvrir l’excellente présentation de Britney Muller de Moz qui est aussi jolie que sensationnelle en SEO : https://moz.com/blog/what-is-bert

Nous allons donc attendre pour voir en 2020 si le langage naturel va remplacer les mots clés :O

Recherche Vocale : encore et toujours

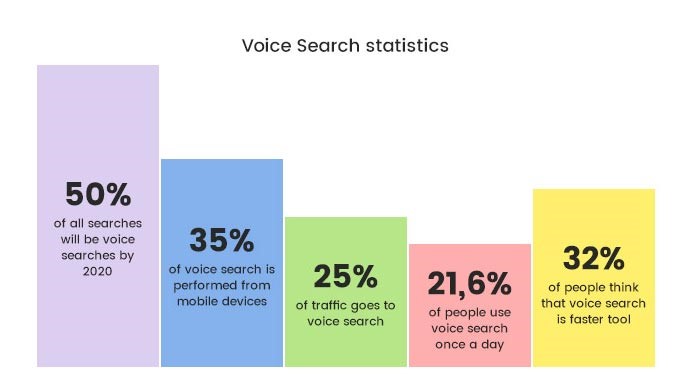

Voici un sujet qui a besoin vraiment de mis à jour. J’avais annoncé dans mon billet concernant la recherche vocale de 2017 et puis dans tendances SEO 2019 : 4 axes de développement en référencement que celle-ci représenterait désormais 50% de la recherche en 2020 :

Comscore annonce que d’ici 2020 50% de toutes les recherches seront effectuées par la voix (sans pour autant gruger dans nos recherches traditionnelles via clavier)

Qu’en est-il donc maintenant qu’on est rendu en 2020 ? Voici les top statistiques glanées sur le web :

- Les achats basés sur la voix devraient atteindre 40 milliards de dollars en 2022

- En part de marché, cela signifie que les dépenses de consommation via les assistants vocaux devraient atteindre 18% d’ici 2022

- 60% des utilisateurs de smartphones ont essayé la recherche vocale au moins une fois au cours des 12 derniers mois.

- 55% des adolescents utilisent quotidiennement la recherche vocale.

- En termes de précision, Google Home est le gagnant jusqu’à présent en répondant correctement à 81% des requêtes, en moyenne.

- Les 3 mots clés les plus courants dans les expressions de recherche vocale sont « comment», « quoi » et « le meilleur ».

Pour être franc je n’ai pas trouvé de mise à jour de la part de Comscore, donc on va s’en tenir aux chiffres de 2018 qui sont comme suit :

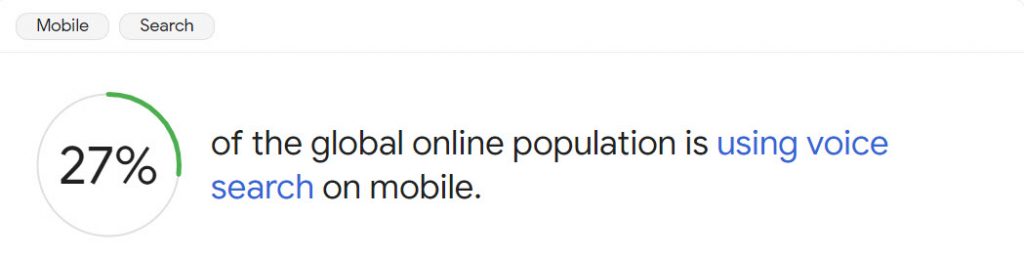

Mais en ce qui a trait à la recherche smartphone, on peut s’appuyer sur les data de Google :

Bon c’est déjà pas mal et Google a affirmé par le biais de @johnmu que nous aurons accès à ces requêtes au sein de la GSC contrairement aux requêtes sur les assistants tels que Google Home :

Nous devons nous préparer pour le VSO désormais et pour je peux vous dire que c’est efficace car on fait d’une pierre 2 coups : featured snipets + vocie search !

Je vais récapituler ci-dessous les recommandation, une fois de plus, de façon sommaire :

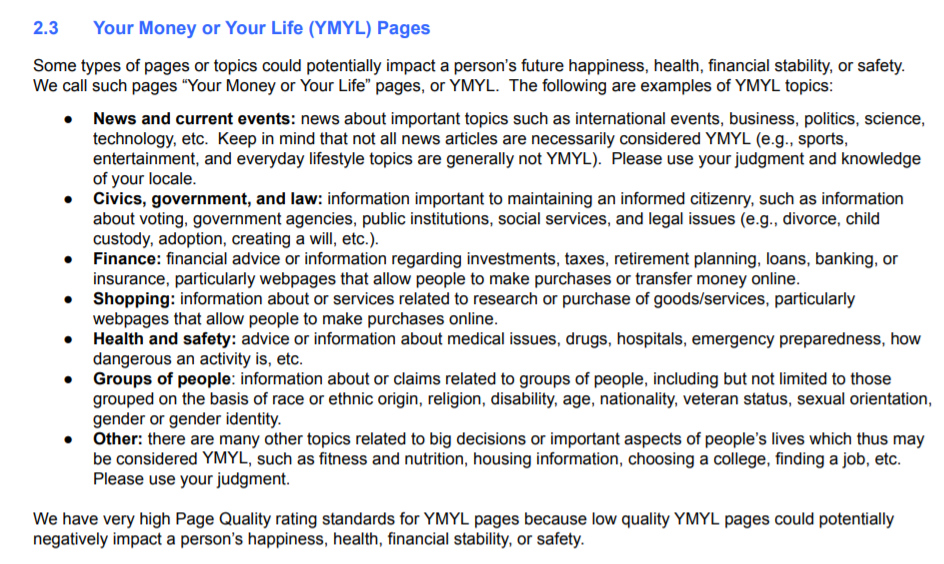

- Optimisez pour des réponses riches: Knowledge Graph, Knowledge Panel, Knowledge Box, Featured Snippet, RIch Answer…tout ça doit vous parler car les réponses riches sont de plus en plus utilisées par Google selon Stone Temple :

- Ré-imaginez et restructurez votre contenu: La recherche vocale étant beaucoup plus conversationnelle, nous devons tous analyser à nouveau notre contenu et sa structure. L’objectif devrait être d’inclure des questions et réponses succinctes pour améliorer la présentation du contenu et le rendre plus convivial pour la recherche vocale.

- Utilisez un langage conversationnel pour le contenu: Être conversationnel est une caractéristique principale d’une requête de recherche vocale, et nous devons en tirer parti. Plus nous utilisons un langage robotique dans notre contenu, moins nous avons de chances d’apparaître dans les résultats de la recherche vocale.

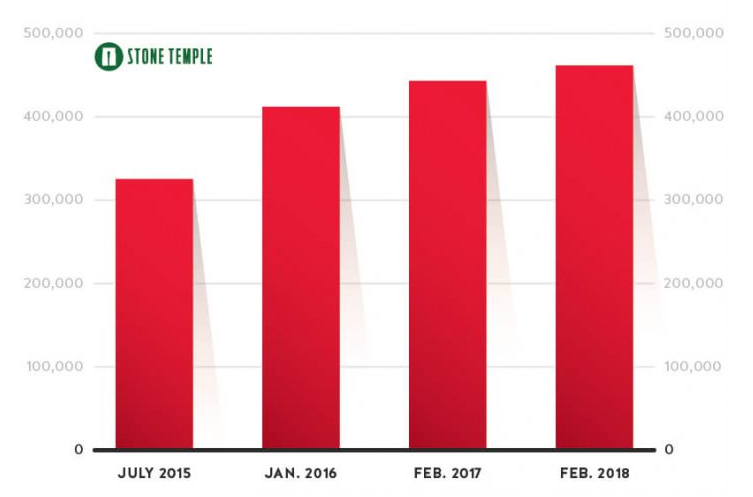

- Cibler des expressions de mots clés à longue traîne: la figure ci-dessus de Microsoft suffira è vous convaincre normalement !

- Améliorez le temps de chargement de votre site Web: En ce qui concerne les recherches vocales, les règles sont à peu près les mêmes que pour le mobile. Les chercheurs vocaux ont besoin de résultats immédiats et si vous avez un site Web lent qui prend une éternité à charger, votre contenu ne sera pas utilisé pour répondre à des requêtes verbales.

- Faites attention au mobile: Le mobile bat facilement les autres appareils en ce qui concerne les requêtes de recherche vocale, car la plupart des questions verbales sont posées sur le mobile. Vous devez être bien préparé pour offrir une expérience utilisateur mobile hors du commun.

- Tirez parti des fiches Google My Business: Nous savons déjà que les gens utilisent leur voix pour des recherches « à proximité ». Le facteur qui détermine si vous êtes éligible comme résultat pour ces recherches est votre fiche GMB.

Enfin, je vous renvoie à mon billet plus complet sur les astuces pour la recherche vocale comme la présence d’un FAQ sur votre site et n’oubliez pas que désormais Google supporte les Schema speakable dans ses résultats de recherche (pour le moment en anglais seulement ☹

Voici le tweet récent de @dannysullivan à ce sujet mais toujours réservé aux US (12/12/2019):

Speakable is no longer restricted to news content; we’ll be updating our documentation on this. However, using Speakable markup on any site isn’t a guarantee that the Google Assistant will always use it. Speakable also remains a beta feature.

— Danny Sullivan (@dannysullivan) December 12, 2019

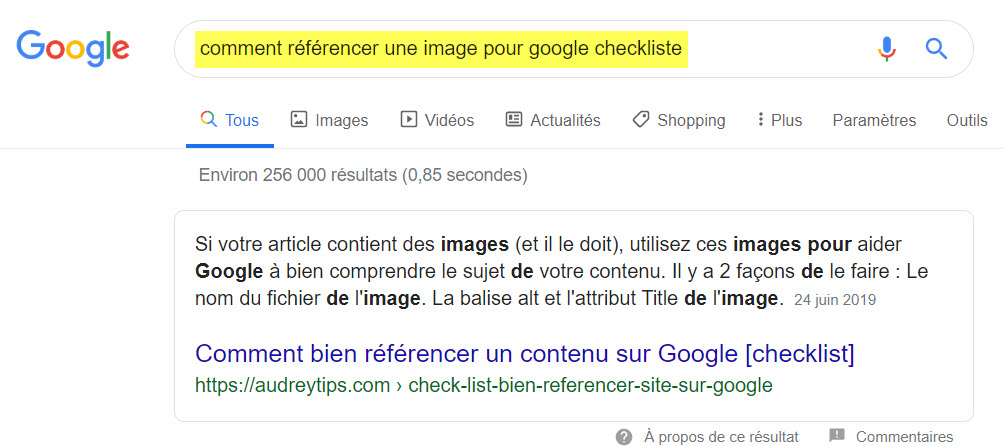

Recherche visuelle : l’opportunité manquée des référenceurs

Voici un domaine qui est très peu documenté dans les anales du SEO, Oui on sait on optimise les images pour le Web (format JPG, PNG, GIF), on met un nom de fichier bourré de mots clés et on ajoute un AL svp. Voici en gros ce que nous autres référenceurs on préconise pour nos clients qui ont des images. Allez, on va plus loin on rajoute un Schema pour images et on les ajoute au Sitemap : that’s it !

Idem pour les vidéos, on va ajouter probablement le transcript pour aider à Google à comprendre, on va hoster la vidéo sur les platformes populaires comme YouTube et on va taguer et taguer jusqu’à ce qu’on soit à court d’idée. Dans le meilleur des cas on également jouer sur la description pour glaner un backlink vers la page d’origine mais ça s’arrête là.

Mais la vraie question qui se pose c’est quelle stratégie de contenu pour les images et les vidéos. Pourquoi est-ce important ? parce que @randfishkin a rapporté les data de Jumpshot et elles sont amusantes quant à l’importance de la recherche visuelle :

On voit que derrière il y a Google Images et YouTube et ça date de 2018. Moi je pense que sur mobile comme on est pressé c’est encore plus flagrant mais malheureusement on n’a pas le détail.

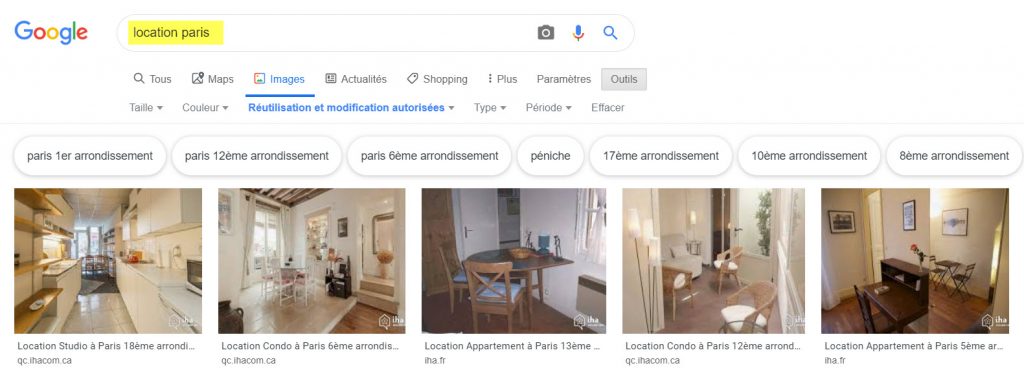

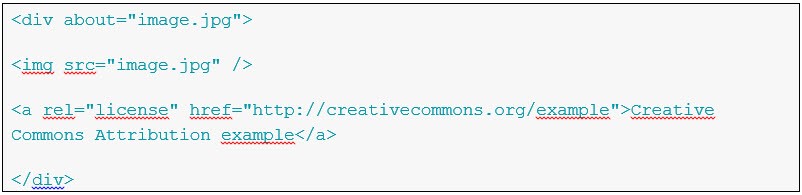

Voici un exemple d’un client qui a maintenant une landing page sur Google Images seulement parce qu’on a implémenté le tag RDFa pour la license CC BY de Creative Common :

On reconnaît le logo du client en question, pour l’implémenter voici la source sur mon blog :

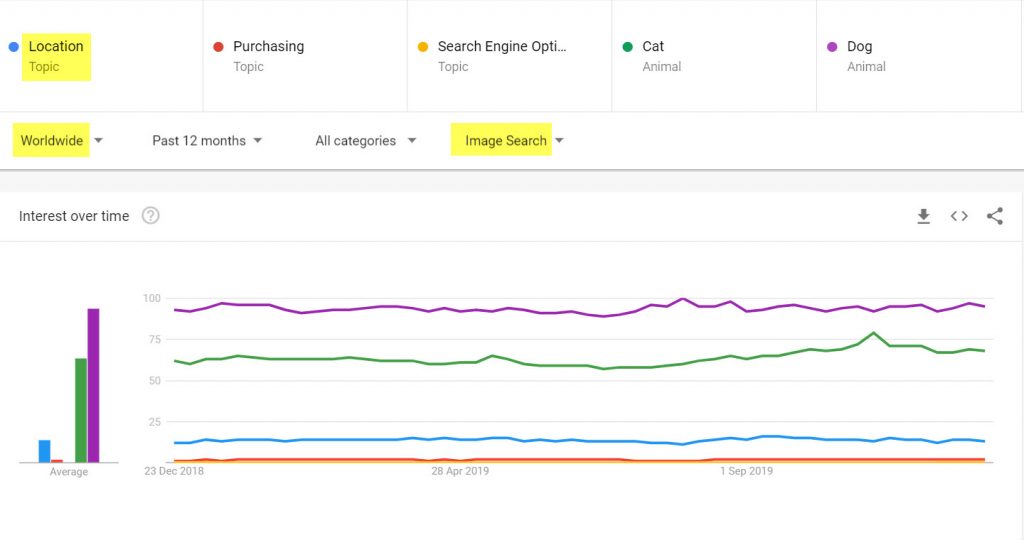

Ok mais pourquoi faire un tel effort ? parce que dans le domaine de location nous avons une opportunité pour les images réutilisables libres de droit :

Donc, bien que moins demandées que pour les animaux, la location consomme de la recherche par images plus que la vente et bien plus que le SEO qui se veut paresseux et demande des infographies à tout bout de champ ! Alors voici ma checklist pour la recherche visuelle :

- Quelle est la demande online pour votre secteur ?

- Que font les compétiteurs pour combler cette demande ?

- Avons-nous les moyens de les dépasser au niveau quantité et qualité ?

- Pouvons nous utiliser des canaux d’amplification comme les réseaux sociaux ?

- Y a-t-il une opportunité pour obtenir des backlinks si elle est réutilisable ?

Une fois répondu à toutes ces questions, concevez une stratégie de production de contenu qui accompagne le contenu texte pour les différents format : image, vidéo, infographie…etc.

Recherche locale : la plus efficace des stratégies SEO

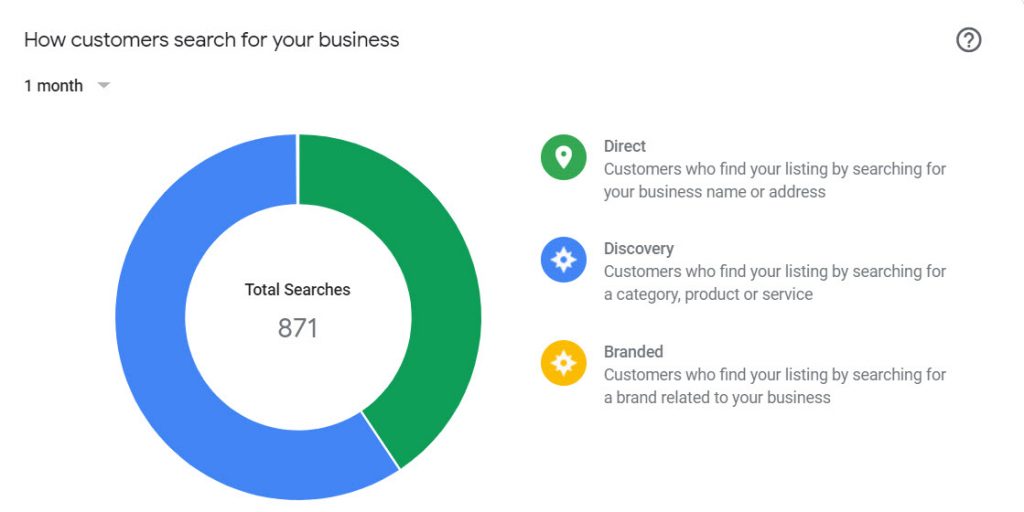

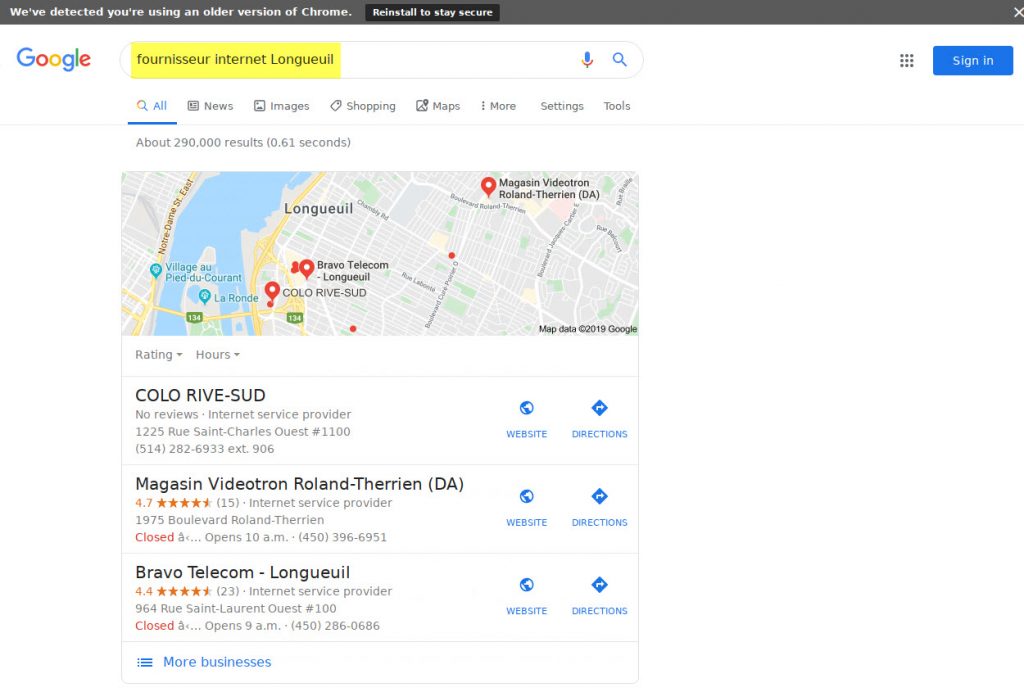

Nous voici sur mon terrain de jeu préféré ! Nous avions loué un bureau pour Bravo Telecom à Longueuil cet automne et on avait besoin de se faire voir. Aller chercher les premiers résultats organiques sur le mot clé « fournisseur internet Longueuil » aurait été coûteux. Vous savez quoi ? je me suis appuyé simplement sur la fiche GMB que j’ai vérifiée bien sûr et nous avons fait de l’optimisation locale notre seule stratégie pour ce bureau. Actuellement on est numéro 1 dans Google Maps ce qui fait sonner le téléphone, nous ramène des clients à pied et draine des visites vers le site web :

Source : screen shot de mon outil préféré BrigthLocal

Source : screen shot de mon outil préféré BrigthLocal

Et ce que ça donne après 3 mois d’existence sur la carte, plus de 60% de recherches locales où on est affiché sont via la découverte (pas Bravo) et Google Maps représente 2 fois Google Search !

Oui, vous devez le savoir, il y a eu une grosse mise à jour dans Google Local dernièrement : on parle de Bedlam où Google a incorporé la correspondance neuronale comme l’indique le tweet ci-dessous :

In early November, we began making use of neural matching as part of the process of generating local search results. Neural matching allows us to better understand how words are related to concepts, as explained more here: https://t.co/ShQm7g9CvN

— Google SearchLiaison (@searchliaison) December 2, 2019

Maintenant que fait-on avec ça ? je vous renvoie à l’Excellent post sur Search Engine Land. En gros voici ce qu’il faut retenir pour 2020 :

- Pensez géolocalisation: votre bureau est-il proche des chercheurs ?

- Vérifiez votre listing sur tous les site importants: Yelp, PJ, FB …

- Utilisez un ton qui répond à E-A-T vu plus haut dans votre description

- Utilisez les signaux sur votre site pour populariser votre fiche GMB

- Restez actif et cohérents via les Posts, Produits et Offres de Google Maps

Bien sûr, après la mise à jour Possum qui a fait trembler plus d’un, on doit attendre de comprendre mieux cette mise à jour par ailleurs confirmée par Google entre temps.

Recherche Mobile : plus de la moitié des recherches Google

Heu, pensez vous que nous avons encore besoin d’insister sur l’importance de pensez mobile d’abord ? Si oui reprenez depuis le début car on a cité ce mot une dizaine de fois sans oublier que j’ai une chance sur 2 de me tromper en prédisant que vous lisez ce blogpost sur votre mobile : right ?

Source: StatCounter Global Stats – Platform Comparison Market Share

Bon alors le mobile nécessite rapidité, bonne expérience utilisateur, des pages AMP pour les news et bien sûr une bonne canonicalisation si vous utilisez un site dédié (genre m.site.com). Pour ce dernier point encore une fois @johnmu a été catégorique récemment en annonçant la mort de cette stratégie :

“Of course, the the best way to handle it, or rather the easiest way to handle it, would be to use a responsive site. Or you choose dynamic serving where you just have a single URL where you don’t have all of these differences between the m-dot and the desktop version.

Every time you you have a separate mobile version or a separate version of the site, again, it just makes everything a little bit more complicated. It’s not that we will stop our support for m-dot versions it’s just that if you have this set up and we’ve shifted to mobile-first indexing […] then it’s possible that you will see this.”

Regardez comment la Google Search Console s’améliore spécialement pour les rapports d’utilisabilité, de vitesse de chargement, d’optimisation AMP et d’indexation !

Conclusion pour les tendances 2020

Pour conclure ce post un peu long j’avoue mais en tant qu’expert en SEO vous ne pouvez pas m’en vouloir. Voici mes prédictions pour 2020 : le technique reste un fondamental avec du contenu haute qualité utile qui attire des liens de qualité naturellement, bien exposé sur les médias sociaux, aimé et partagé pour sa pertinence. Google va continuer à enrichir son Knowledge graph à l’instar de ce qu’il avait annoncé en 2012 et va appliquer cette connaissance des entités web pour déterminer le score E-A-T de chaque page en se basant sur l’empreinte web laissée par le contenu et ses auteurs. Le JS va continuer à représenter un challenge pour nous autres SEO en 2020 mais bon… work in progress pour les moteurs. Google va tout faire pour s’écarter de la correspondance exacte des mots clés et se concentrera plutôt sur la tangente de la sémantique utilisée, en l’occurrence celle utilisant un ton conversationnel va être priorisée pour livrer les résultats de la recherche vocale on the rise. La recherche visuelle va enfin être révélée avec des stats confondantes, le local va vivre le même cauchemar de mises à jour que nous connaissons en recherche standard et enfin le mobile va damer le pion à tout ce qui vient d’être cité puisque tout repose sur sa performance désormais.

Nous sommes en plein dans l’ère du mobile et des assistants vocaux.

Bonne et heureuse année 2020 !