Liste 20 Étapes pour référencer votre site dans les moteurs de recherche. État de l’art du référencement Google SEO

Cet article est une nouvelle mouture des précédentes versions que j’avais réalisées auparavant, en 2010 (Référencement Google SEO de site en 15 étapes) et en 2012 (Bonnes pratiques SEO en 20 étapes). Le but est de vous aider à y voir clair au niveau des bonnes pratiques SEO pour référencer son site. Les étapes décrites ici sont cruciales pour réussir une campagne SEO et cette analyse a été largement reprise sur la toile. J’aurais pu succomber à la tentation d’ajouter de nouvelles étapes d’optimisation mais l’essentiel est d’avoir une checklist que chaque référenceur pourra enrichir de sa propre expérience en référencement naturel SEO Google.

Table des matières :

- Recherche de mots clés

- Sémantique et pertinence du contenu

- Contenus alternatifs

- Utilisabilité et UX

- Renseignent des balises métas

- Utilisation des tags Sémantiques

- Optimisation du code et scripts

- Récriture des URLs

- Versions site mobile, local et Multilingue

- Gestion des liens et pages introuvables

- Respect des normes w3c

- Optimisation de la vitesse du site

- Fichier robots.txt et envoi des sitemap

- Soumission du site aux moteurs et annuaires

- Inscription dans les TOP5

- Création de pages de profil

- Développement de réseau de liens

- Lancement d’une campagne de liens sponsorisés

- Utilisation des outils web 2.0

- Mettre en place des outils d’analyse

Introduction aux changements algorithme Google

Pour conduire une bonne campagne SEO, il est important de tenir compte des changements qui occurrent maintenant sur une base quotidienne au niveau Google (plus de 500 updates par an). Ces changements sont devenus fréquents au point où Google a décidé en 2012 de les publier sur une base mensuelle dans son blog http://insidesearch.blogspot.com , puis il s’est arrêté pour nous laisser avec les journalistes spécialisés comme +Barry Schwartz, +Danny Sullivan et d’autres bien sûr aux USA. Pour moi, je suis les plus importants via la page de MOZ: « Google Algorithm Change History ». Mais rien ne vaut un abonnement quotidien aux blogs SEO.

En 2012, j’avais résumé les principaux changements en cinq grosses tendances :

- Aspect fraicheur : On estime que 30% du trafic de recherche est impacté.

- Aspect local : Les recherches locales représentent désormais 13% du trafic global.

- Aspect mobile : 6,5% du trafic provient du Mobile au Canada

- Aspect social : des études ont révélé qu’une infime partie (0,5 à 1% en B2C) du trafic est concernée, mais dans certains cas cela peut aller jusque 25%.

- Aspect sémantique : 10 à 20 % des requêtes seraient concernées. Google ne renvoie plus le trafic vers la source mais répond directement dans ses SERPs pour certaines requêtes.

Pour résumer, en 2012, c’est plus de 70% du trafic de recherche qui s’est trouvé affecté , et si on ajoute l’effet Panda qui porte sur plus de 12% des recherches faites au niveau anglophone, on dépasse les 80%, d’où ma mise à jour du billet sur le référencement Google SEO surlignant les nouvelles stratégies.

Pour résumer, en 2012, c’est plus de 70% du trafic de recherche qui s’est trouvé affecté , et si on ajoute l’effet Panda qui porte sur plus de 12% des recherches faites au niveau anglophone, on dépasse les 80%, d’où ma mise à jour du billet sur le référencement Google SEO surlignant les nouvelles stratégies.

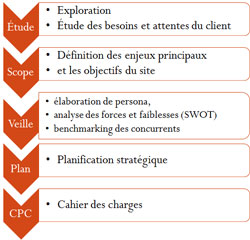

Dans la version 2012, il y a un point important qui s’est ajouté et qui me semble plus incontournable que par le passé : une bonne planification stratégique. En effet, j’ai commencé à blogger sur ce sujet depuis la fin de ma maîtrise avec une étude de cas postée sur Youtube (Juin 2010). Depuis, j’ai mis en ligne une présentation que j’ai donnée à Montréal Intelligence et stratégie internet et publié un billet sur le sujet. Cette planification est rendue indispensable par la nature de la compétitivité qui est devenue féroce à cause notamment d’un gain en connaissances techniques d’optimisation SEO, et une croissance exponentielle des sites mis en ligne : nous approchons du seuil du milliard de sites web :

Mais il y a aussi d’autres aspects qui entrent en ligne de compte et qui nous imposent de nouvelles règles de référencement SEO, dont font partie l’analyse du comportement du visiteur sur site et le taux de conversion de ce dernier.

« So if you’re a good SEO, someone who is paying attention to conversion and not just rankings on trophy phrases, then you might want to pay some attention to testing different meta descriptions that might result in more clickthrough and possibly more conversions. » Matt cuts – Google, Mars 2012.

L’élaboration de persona par exemple aidera à adapter le message dépendamment de la clientèle cible, de la plateforme et de l’intention de recherche. Le benchmarking des concurrents aidera à définir sa stratégie sociale mais aussi sa stratégie de contenu à mettre en place (presse, événements, vidéos…etc.). Rappelez-vous la récente sortie de Matt Cuts où il déplore que trop de référenceurs SEO se concentrent sur la technique pas le contenu !!

Dans cette nouvelle version 2014, l’aspect du contenu est encore plus important, notamment avec le déploiement plus poussé du Knowledge Graph, des filtres Panda, et de manière indirecte le filtre Penguin : n’est-ce pas le meilleur contenu qui gagne des liens naturellement ?!

Mais ce n’est pas parce que Google ne nous dit pas tout que nous ne comprenons pas ce qui se passe : Inter connectivité, autorité, popularité, degré d’expertise, et autres facteurs de classement que vous pouvez trouver sur les études des facteurs de classement font leur entrée chaque année. Attention toutefois de ne pas tomber dans le piège de la liste des 200 ranking SEO factors Google : ce n’est qu’un Mythe!

Moi-même modestement j’apporte ma contribution à la connaissance collective en rapportant régulièrement dans le cadre de la rubrique « Analyses SEO » les amendements apportés à l’algorithme de recherche Google et notamment les plus marquants : Google caffeine, Google maps, Google mobile, Google Panda, Google plus, Google sémantique…

Maintenant pour aller à la source directement, Google, Yahoo! Et Bing se sont efforcés de créer des espaces d’informations dédiés aux Webmasters pour les informer des bonnes règles de développement de sites pour être pris en compte sur leur index. Ainsi on peut découvrir sur Google Wemaster Tools , les consignes concernant la conception et le contenu, les consignes techniques et celles relatives à la qualité. De la même manière, dans Bing Webmaster Center Tools, on peut trouver les grandes lignes directrices permettant un bon référencement de site sur le moteur de BING de Microsoft.

Alors, nous allons énumérer les mêmes étapes de référencement listées dans l’article original de 2012 et les enrichir de notre connaissance en 2014. Un genre d’état de l’art SEO mais orienté pratique plutôt qu’un article académique qui serait réservé à une élite. Bonne lecture…

Référencement naturel SEO Google en 20 étapes

1. Recherche de mots clés

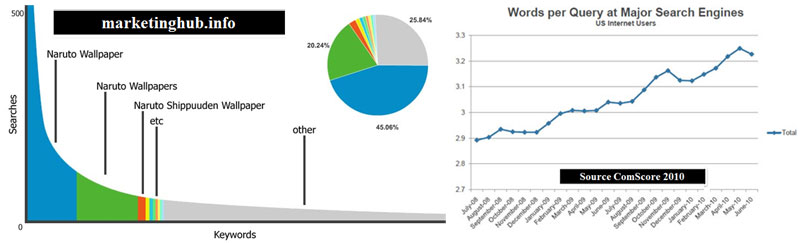

Bien que les mots clés ne soient plus aussi importants que par le passé, ils définissent le sujet et la catégorie du site. Avant de lancer le développement, il est important d’identifier les termes utilisés dans la recherche web liés à la thématique du site. Cela équivaut à choisir son créneau sur le web en évitant toutefois une concurrence intense car pour tout nouveau site, il s’agit d’un challenge de prendre la place de ceux déjà connus par les moteurs. Mais aussi, il faut cibler des mots clés que les internautes sont susceptibles de saisir. En règle générale on se limite à trois expressions clés composées de trois mots. Pour faire ce choix, aujourd’hui on dispose d’une batterie de générateurs de mots clés dont, le plus connu et le plus ancien, Google Adwords. Mais il ne faut pas omettre de comparer ces résultats avec ceux d’outils indépendants tels que Keyword Discovery. Mais pour les sites d’e-commerce, il existe un outil très riche en informations et qui s’appelle Google Insights for Search. Ce dernier est formidable puisque les recherches peuvent être affinées pour les produits par région et par catégorie. Il ne faut pas négliger toutefois les mots clés sémantiquement proches en ayant recours éventuellement à Yooda Suggest. Ici la stratégie à adopter est celle d’identifier ceux qui ont un potentiel de drainer du trafic en optant s’il le faut pour les mots clés de longue traine (long tail keywords).

2. Sémantique et pertinence du contenu

Dans cette section, la sémantique du code est un ensemble de pratiques SEO permettant de rendre le code plus « lisible », en hiérarchisant le contenu mis en forme (Titre principal, sous-titre, texte du contenu, emphase d’un morceau de contenu…). Pour cela, on privilégie l’utilisation des schémas de conception en <DIV> en faisant appel aux CSS. Il faut également utiliser au mieux les balises HTML appropriées (<H1>… <H6>, <P>, <STRONG>, <EM>, …) afin de mettre le contenu en perspective du focus qu’on souhaite lui apporter. Les moteurs de recherche donneront un poids plus important aux mots insérés dans une balise <H1> que dans une balise <P>. De la même manière, les mots mis en évidence à l’aide des balises<strong> ou <em> auront plus d’importance. Si vous développez en HTML5, vous pouvez utiliser les balises <header>, <article>, <aside>, <nav>, <footer> et bien plus encore… je vous y encourage vivement.

Le nom de domaine peut aider grandement dans le référencement de site s’il est bien choisi. De même, les noms de fichiers, les textes de liens et les documents du site doivent reprendre les mots-clés qui caractérisent l’activité du site. On peut voir le site en mode texte avec les yeux d’un robot d’indexation grâce à Lynx ou SEObrowser. Mais maintenant nous avons Fetch as Google dans GWT qui règle tout problème avec même la possibilité d’avoir un aperçu avec le « renderring »

Maintenant pour le contenu, ayez en tête que Google interprète le contenu et extrait de l’information de données non structurées. Alors il est recommandé d’utiliser une sémantique claire et éviter les ambiguïtés. Il existe une nouvelle tendance qui remplace celle du TF-IDF très populaire dans les années 2011-2013, qui s’appelle « Topic modeling » que d’autres appelleront en français « cocons sémantiques » ou autre, mais le principe est très simple et je vous invite à visionner la vidéo ci-dessous de notre ami +Rand Fishkin pour vous familiariser avec :

3. Contenus alternatifs

Pour désigner un élément non-textuel (images, animations flash, JavaScript…), L’attribut ALT permet de donner une information aux robots concernant les éléments de contenu auxquels ils ne peuvent accéder. L’attribut Title doit être utilisé par exemple quand l’image sert de lien hypertexte vers une page définie. Il contient alors la description l’événement qui va avoir lieu. Voire aussi le référencement des images.

Il s’agit bien sûr des attributs « ALT » mais aussi des balises « Object » « Flash » …même dans une Iframe on peut placer une description. Le mieux est d’utiliser un outil comme Seobrowser.com pour voir le site comme un robot ou passer par les outils Google webmaster.

4. Utilisabilité et UX

Nous devons optimiser l’expérience utilisateur mais aussi à la qualité du site au niveau de la conversion :

-

- Architecture : le but est double. Il faut permettre au moteur de crawler le site de haut en bas de manière naturelle via des textes de liens mais aussi de passer le « jus » de bas en haut pour que la HOME reçoive le maximum d’autorité. Pour faire cela je vous renvoie à l’excellent post de @TomSchmitz .

- Navigation : ici le défi est de garder le visiteur sur site car un taux de rebond pour revenir vers les SERPs est un très mauvais signal envoyé à Google. On peut utiliser le fil de fer, la barre de recherche, articles similaires…

- Contenu : Gardons en tête les prévisions de Gartner notamment via sa fameuse « hype cycle » qui montre les attentes importantes en recherche vidéo.

5. Renseignent des balises métas

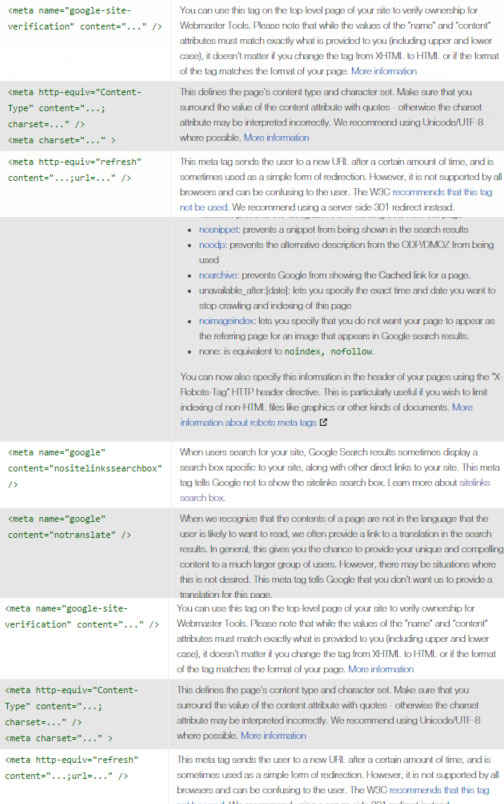

Les balises <Meta> (abréviation de Metadata) ne sont utilisées que par les moteurs de recherche. Depuis 1999, leur importance a considérablement diminué et seule la balise Title est véritablement importante pour les moteurs. Néanmoins, il convient de renseigner les balises Keywords, et Description également. D’autres balises existent de la manière plus ou moins farfelue et ne sont prises en compte par aucun des moteurs de recherche majeurs. Seule la balise Robots est en réalité utilisée pour les droits d’indexation.

Par ailleurs, les propriétés cataloguées par la Dublin Core Metadata Initiative (DCMI), définissent plusieurs dizaines de termes, mais 15 d’entre elles, plus fondamentales, ont été normalisées. Une étude réalisée concernant l’impact de celles-ci sur le référencement des pages Web, a démontré que ces balises ne favorisent pas le référencement et que leurs incidences sont insignifiantes.

Toutefois, ces balises risquent d’être prises en compte dans un futur proche et l’utilisation des éléments Title Description Subject, est préconisée.

Bien que beaucoup déconseillent l’utilisation de la balise Keywords car elle n’est plus utilisée par les moteurs, je conseille toutefois d’y mettre le TOP 3 car certains annuaires s’en servent (comme DMOZ). Google vient de faire un point sur celles importantes (Description, Title, Robots, et Content-type). Puis ne négligez pas les balises Open graph car elles permettent de renseigner le titre, description, URL et image du contenu partagé sur les réseaux sociaux.

Avec la nouvelle sortie de fonctionnalité de recherche sur site à partir des résultats de recherche (Sitelinks) Google vient même d’élaborer une balise méta pour bloquer cette option le cas échéant. Voici la liste des Méta Data comprises par Google mise à jour le que vous pouvez trouver ici.

6. Utilisation des tags Sémantiques

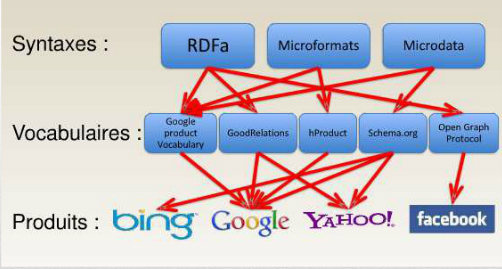

Je dois avouer que j’ai une préférence pour les Tags de Schema.org, malgré qu’il n’y ait pas de règle unique comme le démontre la figure ci-dessous concernant les vocabulaires existants :

Pour plus d’information, je vous renvoie à mon billet « Référencement SEO et web sémantique », mais on sait maintenant que le futur du web est sémantique et que les tags mis à notre disposition par les moteurs permettent une meilleure compréhension et souvent un affichage plus attrayant des résultats (rich snipet). Ok ils ont laissé tomber le Tag auteur mais ce n’est qu’en apparence car l’autorité des auteurs est toujours prise en compte. Mes préférés des tags restent : entreprise, personnes et avis, produits et reviews qui influent directement sur le positionnement. Une utilisation extraordinaire en référencement reste le balisage du catalogue produit pour échange standard avec partenaires et revendeurs, d’où la possibilité de drainer l’autorité et garder la main sur la source officielle (certaines marques se font devancer par leurs affiliés !). Et puis mentionnons quand même que le gain en trafic naturel de Best Buy de l’ordre de 30%, après avoir implanté la solution Good Relations est vraiment motivant.

7. Optimisation du code et scripts

Des technologies comme le FLASH et maintenant AJAX, utilisées en masse sur un site, sont de véritables obstacles au référencement de celui-ci. Les robots ne captent et analysent que le code HTML. Les scripts complexes peuvent rebuter les robots à approfondir leur recherche.

Les scripts et requêtes serveurs doivent être simplifiées et optimisées pour répondre dans le meilleur délai au client. De plus il faut gérer correctement la position des scripts dans les pages web. Dans le cas des sites e-commerce, on utilise souvent les variables de sessions, pour gérer par exemple le panier d’achat. Il s’agit d’un facteur bloquant pour le référencement. Pour y remédier, on peut désactiver les sessions quand le visiteur est un robot d’indexation.

C’est encore plus clair maintenant avec la prise en compte de la vitesse du site pour le classement ainsi que la portabilité des données sur les différentes plateformes.

8. Réécriture des URLs

Il est important que toute URL soit propre, unique et signifiante, intelligible par l’utilisateur et caractérisant le plus possible le contenu de la page. Pour cela, il faut créer un fichier .htaccess qui va gérer certains paramètres du serveur tels que les redirections, les réécritures d’URL et les restrictions d’accès. Il faudra s’assurer auparavant de l’activation du mod_rewrite.

Par ailleurs, il faut spécifier aux moteurs les pages principales à indexer pour éviter le duplicate content qui est très pénalisant en référencement. Ceci est obtenu grâce au Tag « rel= »canonical » » inséré dans le lien.

Rappelons également qu’une url genre « mon domain.com/exemple » n’est pas considérée idem « www.mondomaine.com/exemple/ » Autant fermer donc les URLs. Et puis c’Est quoi cette idée de mettre des URls non ASCII avec des accents, des espaces et autres caractères spéciaux : une pratique certainement pas SEO car tout ça crée du contenu dupliqué ou au pire des pages 4xx voir 5xx.

9. Versions site mobile, local et Multilingue

Google est clair à ce sujet en considérant le fait d’avoir le même contenu servi avec différents rendus selon le navigateur ou l’interface, n’est pas du cloacking. Je conseille toutefois de rajouter une balise « canonical » pour indiquer l’URL à indexer en cas de duplication si vous utilisez différentes URLs pou le mobile que ce soit avec un site parallèle ou en dynamic serving. Pour les sites multilingues, Google met à notre disposition un nouvel attribut qui peut l’aider à y voir clair entre les différentes versions (hreflang= »x »).

Dans le chapitre du local, pour la géolocalisation, un test a révélé que l’utilisation de sous-domaine + répertoire était le mieux adapté. En effet, j’utiliserais le sous-domaine pour la localisation et le répertoire pour la langue et cette solution offre le confort de combiner les deux. Pour l’aspect mobilité. La récente sortie de Duanne Forester (qui ne fait plus partie de l’équipe Bing malheureusement) montre qu’un simple répertoire genre www.votresite.com/mobile est plus adapté : Optimisation de sites pour toutes les plateformes. Rappelez-vous Google considère désormais les sous-domaines comme des répertoires, alors autant utiliser une structure d’URLs qui colle à l’architecture du site.

Pour le référencement local, je mets à votre disposition mon billet d’analyse SEO des facteurs de classement local : Les facteurs SEO référencement local (local SEO). Une nouvelle version de cette étude vient de sortir en Octobre signée +David Mihm grand spécialiste de la question que j’ai eu l’occasion de rencontrer aux USA et qui a rejoint l’équipe de Moz en 2013.

10.Gestion des liens et pages introuvables

Il faut éviter dans la mesure du possible les pages « not found ou 404 ». Même si ce problème est géré par le fichier .htaccess mentionné ci-dessus, il est préférable, si des URLs ont été modifiées mais que les pages sont restées les mêmes, d’utiliser le code « HTTP 301 » ou 302. Mais comme le conseille Google dans l’envoi des sitemap, seules les URLs en 200 sont prises en compte. Alors évite les redirections internes 3xx, les pages 4xx et encore pire les erreurs serveur 5xx.

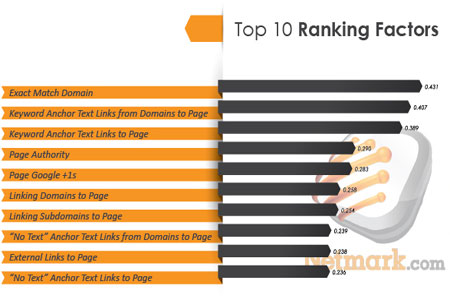

Les mots qui composent le lien pointant vers une page renseignent sur le contenu de celle-ci. Il est donc recommandé d’utiliser du texte explicite. En plus, l’attribut Title pour les liens semble avoir son importance. Il s’agit certainement de la tactique qui a le plus de poids comme le révèlent les différents sondages d’opinion. Voici le top 10 de l’étude Netmark :

Par ailleurs, j’ai vraiment été étonné de voir sur un guideline de Google sur le déplacement de sites qui fait mention de l’utilisation de XENU. Alors je ne peux que vous le recommander doublement puisque j’en suis fan même si Screaming Frog est bien plus puissant ou IIS SEO Tool de Micosofté.

Par ailleurs, j’ai vraiment été étonné de voir sur un guideline de Google sur le déplacement de sites qui fait mention de l’utilisation de XENU. Alors je ne peux que vous le recommander doublement puisque j’en suis fan même si Screaming Frog est bien plus puissant ou IIS SEO Tool de Micosofté.

11.Respect des normes w3c

Le code HTML du site, ainsi que les feuilles de style CSS utilisées doivent respecter, dans la mesure du possible, les normes établies par le W3C. Pour cela, une validation en ligne est requise. Si le site est bien conçu, le contenu des pages liées sera alors analysé avec pertinence par les robots (crawler).

Bien que ce point ne fût pas confirmé dans les différentes études de facteurs de référencement comme SEOMOZ, il est recommandé de le passer avec succès car cela garantit une compatibilité avec les navigateurs et ça permet un affichage plus rapide, ce qui n’est pas sans conséquences sur la performance SEO du site en tant que tel.

12.Optimisation de la vitesse du site

Une des innovations majeures, en terme de recherche web, est la prise en compte de la vitesse de téléchargement comme facteur déterminant pour le référencement. Ainsi, Matt cutts responsable de Google Webspam, l’a annoncé sur son blog , et a aussi déclaré à Webpronews que ceci a pris effet dès 2010.

Aujourd’hui nous avons une pléthore d’outils, en commençant par l’outil de Google lui-même Page Speed Insights, celui de GTmetrics fait l’unanimité Site Performance Optimization, mais je viens de découvrir un dernier qui a l’avantage d’être français de surcroît : Dareboost. Essayez-le !

Il est possible d’utiliser des outils tes que « CSS Optimizer » et « JavaScript Optimizer » en plus des optimiseurs d’images.

13.Fichier robots.txt et envoi des sitemap

Avant de procéder à une soumission aux moteurs de recherche et annuaires, il est important de bien concevoir son fichier robots.txt. On indiquera donc aux différents moteurs les pages à indexer et celles à ne pas prendre en compte. Attention à ne pas bloquer les fichiers CSS et JavaScript comme vient de l’expliquer Google dans son récent billet : Updating our technical Webmaster Guidelines

Il est aussi important de concevoir un plan de site, explicite au format Html qui reprend tous les liens du site avec une description brève des pages en relation directe avec leurs titres. Concernant les sitemaps, Google exige le sitemap au format XML, de même pour Bing.

En plus du traditionnel sitemap, nous avons maintenant la possibilité de soumettre des plans de site pour les images et vidéos, et d’inclure l’adresse de ceux-ci dans le fichier robots.txt. Ne pas oublier également que l’attribut « hreflang » pour les sites multilingues peut être implémenté également via le sitemap. Plus d’informations dans mon post : Référencement SEO international

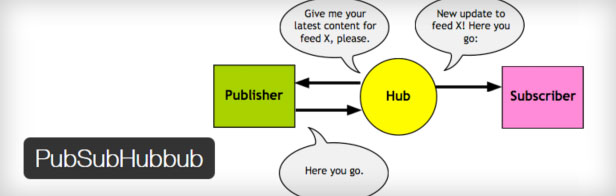

Et puis n’oublions pas que les deux moteurs encouragent l’utilisation de Feed RSS pour indexer plus rapidement. Google va plus loin en demandant d’utiliser PubSubHubbub.

14.Soumission du site aux moteurs et annuaires

En référencement naturel, il existe deux aspects : indexation et positionnement. Une bonne indexation favorise toutefois un bon référencement. La plupart des moteurs proposent une indexation gratuite par l’ajout de l’Url à leur index. Toutefois, l’indexation du site sur d’autres outils de recherche fera grimper son indice de popularité, ce qui aura des incidences positives sur son positionnement. : Il faut le faire une fois quand le site est nouveau.

Bien que des logiciels existent pour la soumission automatique du site aux moteurs et annuaires, il faut privilégier la qualité à la quantité en procédant à une soumission manuelle. Penguin est dans les parages, ne l’oubliez jamais !

Il faut donc rechercher les annuaires les plus populaires dans l’activité attachée au site et les classer par ordre d’importance. Il faudra par la suite procéder à une soumission manuelle en faisant attention aux champs requis (Titre, description, produits..). Les annuaires listent les sites selon les Tags fournis. Il faut utiliser des combinaisons titre/description uniques pour bénéficier de citations diversifiées.

Pour les moteurs, Google Yahoo! et Bing drainent 92% du trafic, à compléter par Ask et Aol qui sont importants également au Canada et spécialement ce dernier via son index e-commerces : AOL Canada Merchant Member Centre. Google et Bing ont la capacité d’indexer immédiatement les URLs fournies via GWT et BWT alors ne vous en privez pas : créez les comptes Google et Bing Webmaster Tools et soumettez vos URLs manuellement du mois les plus importantes qui vont permettre de crawler le site en entier.

15.Inscription dans le TOP5

Il devient presque obligatoire d’avoir un article sur Wikipédia (ou à défaut un lien externe ou de référence ou image), une entrée gratuite sur DMOZ et puis une belle fiche sur Freebase le nouveau chouchou de Google. Si vous avez le budget, complétez votre travail avec une inscription sur Botw il vous rapportera mieux que les liens payants. Malheureusement l’annuaire Yahoo! a fermé ses portes. Vous pouvez aussi protéger votre site via DMCA.com qui vous donnera un lien PR7 !

16.Création de pages de profil

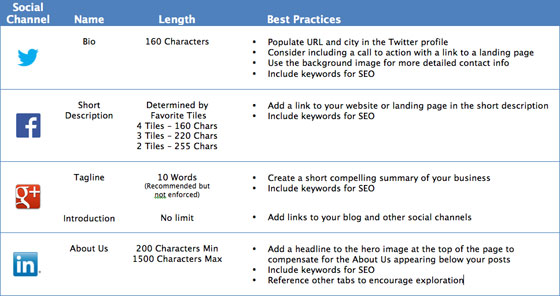

Souvent j’entends cette Remarque: à quoi bon créer un profil si je ne vais pas poster et créer de l’engagement. Au moins 2 réponses intelligentes à cette interrogation : mise de côté des URLs personnalisées avant qu’on vous les pique et l’obtention de liens de domaines avec PR8 et plus même en Nofollow (pour Google+ c’est un Dofollow dans la description).

Les tops 5 que sont Facebook, Twitter, Linkedin, Google plus et Youtube, vous donneront déjà une première visibilité en médias sociaux. En effet, par la simple création de pages de profils sur ces réseaux, vous obtenez des liens en Dofollow de Google (ce qui n’est pas négligeable) et une mention sur Facebook. Maintenant, il faut garder en tête que les discussions donnent plus de sens aux résultats de recherche et donc il faut plutôt engager la conversation que de se contenter d’une présence passive.

Maintenant pour faciliter la tâche et vous donner un guideline facile pour démarrer, rien de mieux qu’une checklist comme celle qui suit :

17.Développement de réseau de liens

Le link Building est la stratégie de développement de liens qui a pour effet d’augmenter l’indice de popularité du site. N’omettez pas de recourir au référencement vidéo très payant et profitez des liens gratuits des sites de réseautage. Privilégiez les sites connus et dotés de PR 3 et plus.

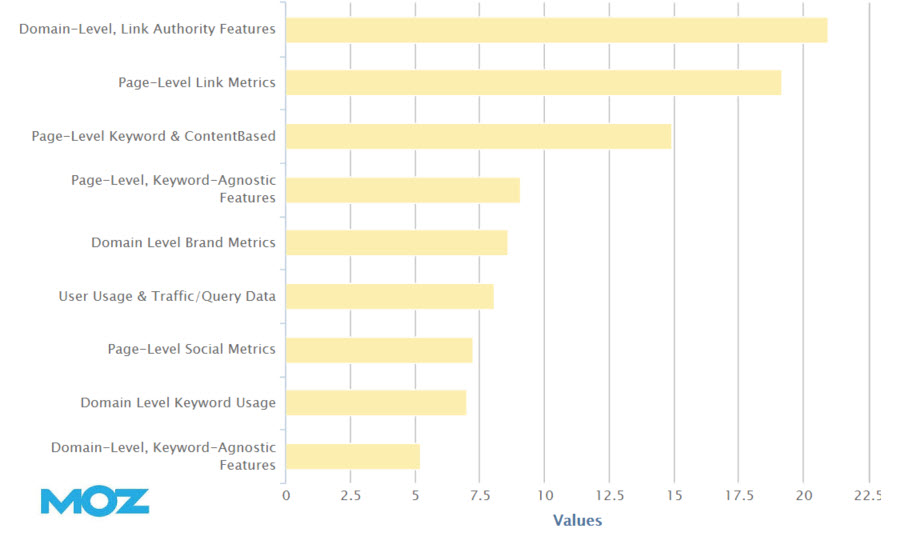

Le développement de réseau de liens ou Link Building en bon anglais est certainement la stratégie la plus payante encore une fois comme démontré dans les différentes études notamment MOZ :

Mais là on est dans une zone grise avec la dévaluation par Google de certains liens et les sorties programmées de Penguin qui devrait également être incorporé dans l’algo sous peu. Toutefois je suis persuadé qu’il vaut mieux en avoir trop que pas assez (la qualité prime sur la quantité toutefois). Il faut varier entre les liens faciles annuaires, communiqués de presse et articles marketing) et ceux plus précieux provenant de sites d’autorité. En effet, si pour les premiers, des techniques existent pour le faire presqu’en automatique avec du spinning à la limite du black hat SEO, pour les derniers, il faudra faire de l’espionnage sur les compétiteurs et entrer en contact avec les Webmasters. Mais ne négligez pas non plus les sites de Bookmark, les Digg like et réseaux sociaux. Dans tous les cas, à mon avis c’est là qu’un logiciel SEO trouve sa justification (Majestic SEO, SEOMOZ ou encore Linkdex). Attention à la vélocité !!

Mais là on est dans une zone grise avec la dévaluation par Google de certains liens et les sorties programmées de Penguin qui devrait également être incorporé dans l’algo sous peu. Toutefois je suis persuadé qu’il vaut mieux en avoir trop que pas assez (la qualité prime sur la quantité toutefois). Il faut varier entre les liens faciles annuaires, communiqués de presse et articles marketing) et ceux plus précieux provenant de sites d’autorité. En effet, si pour les premiers, des techniques existent pour le faire presqu’en automatique avec du spinning à la limite du black hat SEO, pour les derniers, il faudra faire de l’espionnage sur les compétiteurs et entrer en contact avec les Webmasters. Mais ne négligez pas non plus les sites de Bookmark, les Digg like et réseaux sociaux. Dans tous les cas, à mon avis c’est là qu’un logiciel SEO trouve sa justification (Majestic SEO, SEOMOZ ou encore Linkdex). Attention à la vélocité !!

Si vous cherchez à commencer une analyse des liens de vos compétiteurs et que vous avez besoin d’assistance, je ne saurai comment éviter de vous parler du post : Competitive Baclink Analysis

Maintenant, dans le cadre du référencement local, j’avais souligné le manque de compagnies qui ont une politique de récolte de citations (seulement 19%) et donc il y a là une opportunité. Pour maximiser votre optimisation dans ce contexte, une étude qui revêt un aspect académique a été initiée par BIZIBLE que je vous suggère de suivre, bien que de mon point de vue David MIHM est déjà rendu expert dans ce domaine.

18.Lancement d’une campagne de liens sponsorisés

Je sais que je ne ferai pas l’unanimité avec ce point mais avec les 90% des mots clés cachés par Google et toute la gymnastique nécessaire pour extraire un échantillon de GWT, je trouve que c’est encore le meilleur moyen de vérifier son choix de mots clés. Mais pour aller plus loin, je n’ai pas peur d’affirmer heu et fort :

Mettre en place des actions de liens sponsorisés permet d’augmenter l’indice de popularité.

Parce que les deux sont intimement liés. Disposer en interne d’une expertise en référencement naturel permet d’être plus efficace en SEM. Par ailleurs, une campagne qui allie référencement naturel et payant obtient un taux de conversion supérieur de 22 % en moyenne.

Les campagnes SEM (SEO + SEA) présentent l’avantage de s’inscrire dans le cadre d’une stratégie PULL . Par opposition à une stratégie PUSH (dite d’incitation), elles mettent à la disposition des consommateurs les informations sur la marque, les offres et les produits.

Dans le cadre d’un effort de référencement naturel, les liens sponsorisés doivent servir à améliorer son positionnement. Il convient donc de viser un public large et de diversifier ses canaux publicitaires. Ainsi, on pourra utiliser les réseaux Google Adwords, Overture de Yahoo! et Microsoft adCenter. On peut aussi étendre cette action à Miva (anciennement Espotting et FindWhat.com).

Il faut cependant noter que l’achat de mots clés dans une campagne SEA présente des risques puisque les principaux moteurs affichant les liens sponsorisés dans leurs SERPs sont proie aux fraudes qui sont de plus en plus difficiles à détecter comme le résume Ben Benedelman professeur à Harvard.

Quoi qu’il en soit, les deux premiers résultats organiques sont plus regardés par les internautes que le 1er lien sponsorisé.

Un rapport publié par Google sur l’influence directe du référencement payant sur le trafic de recherche va dans le sens de ce que j’ai toujours prôné et que j’ai affirmé ci-dessus. Le but est double : créer de la visibilité mais aussi vérifier les mots clés et la pertinence du contenu. Même si Google et Bing réfutent que l’achat de liens sponsorisé booste le SEO, je reste persuadé du contraire. Dans un post publié par PULLSEO, qui analyse les synergies entre les liens sponsorisés Adwords et le référencement naturel sur Google, il apparaît clairement que les deux sont reliés. Ceci s’explique par le fait que les liens payant drainent un trafic non négligeable vers le nouveau site, du coup les moteurs s’y intéressent et l’essaient sur les résultats. Au-delà de la fameuse Honey Moon de Google, on essaiera d’en profiter pour y rester!

Considérez également une plateforme sociale pour valider votre ligne éditoriale des médias sociaux. Twitter vient d’annoncer la possibilité de viser les mobiles, ce qui à mon sens peut être pertinent pour dégager les tendances des sujets en temps réel.

19.Utilisation des outils web 2.0

Génération des RSS : Au début il y avait les flux RSS.

Dans le monde de l’Internet, l’année 2004 aura été incontestablement marquée par le développement fulgurant d’une nouvelle technologie connue sous le nom de « RSS ». Derrière ce terme quelque peu mystérieux voire magique, se profilent de nouvelles possibilités en matière de veille et de diffusion de l’information.

Nombre d’entreprises ont exploité le système d’agrégation de contenu comme support média en monétisant les espaces publicitaires (exemple : Trust feed). Cette technique particulièrement adaptée aux sites marchands disposant d’une grosse base de données de produits, permet de fournir une liste de produits de façon automatique aux moteurs.

La même année, deux sociétés américaines Moreover et Kanoodle proposaient aux annonceurs d’intégrer des liens publicitaires dans les listes de flux RSS, de plus en plus populaires. En rachetant Feedburner en 2007, alors leader de la publicité via fils RSS, Google a mis la main sur ce marché. La syndication de contenu au cœur du Web 2.0 et du social computing .

Mise en place de blog de marque : en plus de construire une relation saine et transparente avec les fans de la marque, et d’avoir la possibilité de prendre la parole de façon très réactive en cas d’attaque, il permet d’atteindre les objectifs principaux du référencement naturel, à savoir : visibilité et liens de popularité. Il doit être souvent mis à jour, proposer un contenu pertinent et neutre, pinger un répertoire de flux RSS de notoriété tel que technorati.

Social computing : soigner sa réputation en ligne

Le Social Computing est le fruit de l’intersection des sciences sociales et de l’informatique. Il est basé sur la création de contextes sociaux innovants grâce à l’utilisation des nouvelles technologies. On peut donc l’associer aux technologies du Web 2.0 : les blogs, les forums, les emails, la messagerie instantanée, les réseaux sociaux, les wikis, les sites de social bookmarking, etc. Mais on peut aussi directement le raccrocher aux communautés ainsi créées et à leur activité sur Internet : les applications de filtrage collaboratif, les recommandations, les notations, les systèmes d’enchères en ligne et bien sûr la réputation.

Via une activité de social computing, le but est d’augmenter sa visibilité et de générer des BackLinks, pour améliorer la popularité du site. Un forum de discussion est un support où il est très facile d’obtenir des backlinks . Une campagne SMO consiste à participer aux plateformes de micro blogging comme Twitter ou Facebook.

Mise à jour : il est bien entendu que les efforts vont au-delà de ce que j’ai décrit en 2010 puis en 2012. En effet, nombre de tactiques ont vu le jour et des résultats tangibles ont été relevés. Ainsi, au-delà des cinq majors cités précédemment, les champions des médias sociaux en apport de trafic sont incontestablement StumbleUppon (voir Tumblr) et Youtube, suivis de Reddit et Digg. Digg a perdu son aura après la refonte ratée, et puis Youtube nécessite des moyens humains et matériels. Dans tous les cas, il vous faudra du contenu frais à partager et micro distiller, c’est pourquoi je conseille vivement l’utilisation de blog à cet effet. Par ailleurs, nous assistons à la montée en flèche de Pinterset de notre côté et celui de Scoop.it en France. Je vous renvoie à votre stratège médias sociaux pour établir vos priorités et identifier les places que votre niche fréquente

20.Mettre en place des outils d’analyse

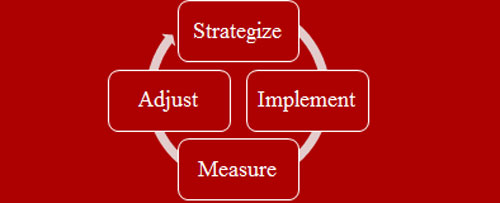

Sans outils d’analyse, on ne peut connaître l’efficacité des différentes actions d’optimisation du site en référencement naturel. Les outils d’analyse fournissent une foule de données statistiques qui permettent de jauger la pertinence des choix effectués. Ces choix pourront être confirmés ou revus pour une correction (cycle de référencement). En complément des rapports d’analyse de référencement fournis par des logiciels spécialisés, les tableaux des web analytiques renseignent sur les flux drainés via les sources de trafic : les moteurs, accès directs, sites référents, E-mailing et abonnements RSS.

Veille stratégique

Avant de commencer à mesurer la portée du travail effectué, et même avant le travail de référencement, une veille concurrentielle s’impose. Ainsi, il est important d’avoir une idée de la vie des sites concurrents (leur fréquentation). Alexa offre des statistiques très intéressantes pour avoir des objectifs sans avoir d’historique web. D’autres sites spécialisés en publicités offrent des données pour les sites importants (Google Adplaner, Quantcast, Compete…). Pour des sites plus modestes, on peut utiliser Statbrain ou Trafficestimate. Mais je vous fais une confidence, je suis un fan absolu de www.similarweb.com et Semrush.

KPI ou indicateurs de performance

En revanche, pour mesurer le retour sur investissent (ROI), chaque entreprise met en place des KPIs qui lui sont propres et utilise un programme de tracking qui donnera les tableaux de bord les plus proches de ceux souhaités. Ces tableaux peuvent être exportés vers Excel par exemple pour un traitement personnalisé ou dans certain cas librement configurés selon les besoins.

Analyse SEO trafic sites web

L’installation d’outils d’analyse de trafic (audience) s’impose donc et le choix est large. Google Analytics est gratuit et se taille la part du lion avec presque 30% du marché. IndexTools, l’outil de Yahoo! est gratuit également et est plus pointu pour certaines actions précises. AT Internet offre Xiti gratuit et propose Analyser solution modulable haut de gamme payante. Enfin Omniture qui se veut le leader de marketing en ligne offre SiteCatalyste.

Analyse SMO Médias sociaux

Mettre en place des outils d’analyse de trafic et monitoring des médias sociaux : Google a décidé de nous priver des mots clés cachés quand il s’agit de recherches via connexion sécurisée et cela concerne presque 90% du trafic naturel (même si Avinash Kaushik nous a donné quelques tuyaux). Je considère alors les rapports sur les requêtes de recherche disponibles via Google Webmaster Tools ou dans Google analytics (quand couplé avec GWT) sont très pertinents pour juger de l’avancement du référencement SEO. Du côté social, si en 2010 je me posais des questions concernant l’utilisation des outils de mesure d’e-réputation (engagement, analyse de sentiment, Net Promoter Score NPS, je me simplifie la vie en utilisant les segments avancés pour les réseaux sociaux sur Google Analytics et aussi en suivant les partages effectués via la plateforme Sharethis après avoir installé le bouton, et aussi des fois pour des besoins ponctuels, je peux utiliser Bit.ly ou Goo.gl qui tous les deux offrent une visibilité suffisante de la vie de l’URL partagée, à condition de la garder intacte. Mais ceci ne cous empêche pas d’utiliser des plateformes dédiées à ce genre de travail comme Hootsuite, Sprout Social et Simply Measured.

Infographie Référencement site sur Google en 20 étapes

Ci-dessous, l’infographie que j’ai produite avec les moyens du bord pour illustrer le processus d’optimisation SEO de sites nouvellement lancés mais cela ne vous empêche pas de reprendre la liste des étapes là où vous êtes rendu dans votre campagne SEO :

Conclusion campagne référencement SEO

Voilà, donc vous avez compris que ce n’est pas fini, avec ce travail d’analyse amorcé, nous allons identifier les succès rapides (quick wins) pour communiquer dessus et motiver les parties prenantes, et aussi prendre note des ratés et corriger le tir dans un nouveau cycle en ajustant les mots clés, le contenu, le message…etc.

Les techniques de référencement SEO vues précédemment ne garantissent pas le positionnement et encore moins le ciblage des clients désirés. En effet, nous n’avons pas abordé par exemple les informations liées à la langue, à l’emplacement du serveur ou le renseignement de Google local. Il faudra donc contrôler que les efforts de référencement donnent le résultat escompté par rapport à la clientèle cible pour commencer. Ceci est obtenu facilement par n’importe quel outil de web analytiques puisque les données de géo localisation sont présentes dans les fichiers logs du serveur. Pensez à partager si vous avez aimé.